I software che controllano la veridicità di un’immagine non sono molto efficienti. Il rischio è di diffondere disinformazione, invece che combatterla

A pochi giorni dall’attacco dal gruppo estremista palestinese Hamas lanciato il 7 ottobre 2023 contro Israele, ciò che ha attirato particolare attenzione nel dibattito pubblico è stata la notizia (ancora oggi non confermata) del ritrovamento di 40 corpi di bambini decapitati nel kibbutz di Kfar Aza, situato nel distretto meridionale di Israele.

Se sulla veridicità di questa notizia ci sono ancora forti dubbi e poche prove, fonti diverse testimoniano una serie di atrocità compiute da Hamas nei confronti di civili israeliani, bambini compresi. Come prova di questi atti compiuti dai miliziani palestinesi, lo Stato di Israele sul proprio account ufficiale di X ha pubblicato alcune foto di cadaveri di bambini carbonizzati (attenzione: il link contiene immagini molto forti).

Alcuni utenti sui social network hanno però messo in discussione l’autenticità di queste foto. Secondo questo filone narrativo, le immagini sarebbero infatti state create digitalmente tramite un software di intelligenza artificiale (IA) con lo scopo di fare propaganda contro Hamas. Ma gli strumenti per verificare l’origine di un’immagine, utilizzati da chi avrebbe svelato la falsità delle fotografie, non sono sempre affidabili e un esito sbagliato rischia di diffondere false informazioni, invece che smentirle.

Da dove nasce la vicenda

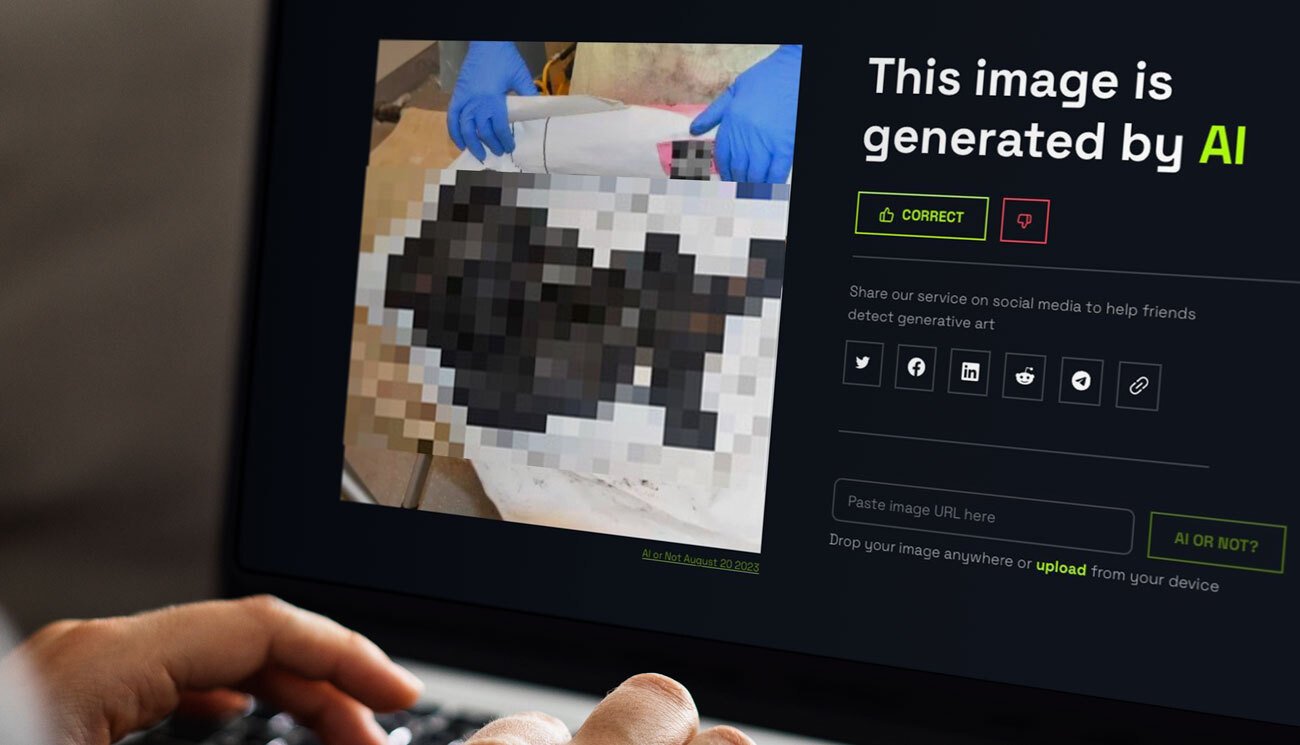

Uno dei primi a sollevare simili dubbi era stato lo youtuber americano Jackson Hinkle, che negli scorsi giorni aveva diffuso false informazioni sugli aiuti americani a Israele. Il 12 ottobre su X, Hinkle ha pubblicato un post in cui spiegava come le immagini dei cadaveri di bambini carbonizzati fossero false perché create con l’ausilio di IA. Il trucco sarebbe stato svelato grazie allo strumento “AI or Not” di Optic, che si descrive come un «servizio internet che aiuta gli utenti a determinare se un’immagine è stata generata con intelligenza artificiale».

La stessa ricerca dell’immagine pubblicata dallo Stato di Israele svolta su Optic dalla redazione di Facta.news in data 16 ottobre (quattro giorni dopo il tweet pubblicato da Jackson Hinkle) mostra però un risultato diverso. La verifica delle immagini tramite questi software non è dunque sempre affidabile.

Sempre il 12 ottobre su 4chan, un forum creato nel 2003 e diventato negli anni un massiccio aggregatore di troll, meme e sottoculture digitali, un utente ha pubblicato la presunta «foto originale» che sarebbe stata poi modificata digitalmente dallo Stato di Israele per veicolare false informazioni a scopi propagandistici. Secondo questa condivisione, il soggetto originale della foto non sarebbe stato un corpo carbonizzato, ma un cucciolo di cane avvolto da un drappo bianco.

Grazie a questi due episodi, su X si è diffusa la tesi secondo cui Israele avrebbe diffuso immagini false per fare propaganda sulle atrocità di Hamas, così da giustificare i bombardamenti nella striscia di Gaza. Senza entrare nel merito delle motivazioni storico-politiche dietro alla complessa questione tra Israele e Palestina, è falso sostenere che l’immagine pubblicata da Israele sia stata generata digitalmente.

Perché l’IA non c’entra

Hany Farid, professore all’Università di Berkeley ed esperto di immagini manipolate digitalmente, ha spiegato a 404, web magazine americano che si occupa di tecnologia, come l’immagine non mostri alcun segno che faccia pensare a un intervento dell’intelligenza artificiale. «La coerenza strutturale, l’accuratezza delle ombre, la mancanza di artefatti che tendiamo a vedere nell’IA mi portano a credere che non sia nemmeno parzialmente generata da IA», ha precisato Farid.

I software per creare immagini IA non sono infatti ancora in grado di creare una scena così dettagliata e precisa. In particolare, la difficoltà sta nel realizzare forme molto strutturate e linee rette, ha sottolineato il professore e, osservando l’immagine, «se si guarda la gamba del tavolo e la vite, tutto appare perfetto e questo non accade di solito con i generatori IA».

A non essere reale è invece la foto del cucciolo di cane, presentata dalla disinformazione come la “foto originale” da cui sarebbe poi partita la modifica del profilo social di Israele. Oltre a delle incongruenze oggettive facilmente verificabili, l’autore che l’ha creata e diffusa ha confermato più volte sul proprio profilo X che si tratta di un meme.

La disinformazione di secondo livello

Gli strumenti che controllano la veridicità di un’immagine grazie all’utilizzo di algoritmi più o meno sofisticati non sono molto affidabili. Al momento, infatti, nessuno di questi è in grado di stabilire con certezza se una foto sia stata creata con intelligenza artificiale e può capitare che portino a esiti sbagliati.

Ad esempio, la foto di due giornalisti palestinesi uccisi dai bombardamenti israeliani su Gaza è stata giudicata dallo strumento di verifica dell’IA di Huggingface come «probabilmente creata digitalmente», anche se l’immagine è reale.

Sempre sul magazine 404, Hany Farid ha definito questo fenomeno come “disinformazione di secondo livello”. I software per rilevare le immagini create con IA, invece che essere uno strumento utile per verificare i contenuti e combattere la disinformazione, rischiano di alimentarla o addirittura di crearla.

Il problema sta nel fatto che la maggior parte di questi strumenti che si trovano in Rete sono automatizzati. Come spiegato dal professore dell’Università di Berkeley, ciò significa che i software si basano su un insieme di fotografie reali e create digitalmente, e addestrano un sistema di intelligenza artificiale per conoscere e rilevare la differenza tra le due categorie. Il livello di accuratezza è pari al 90 per cento, ma la precisione dei risultati inizia a diminuire quando l’immagine ha una risoluzione bassa e non risponde alle caratteristiche su cui il sistema è addestrato.

In casi come questi il software difficilmente riuscirà a dare una risposta corretta: l’intelligenza artificiale può dunque rivelarsi un prezioso alleato nella lotta a ogni forma di manipolazione dei contenuti, ma la tecnologia che è alla base del suo sviluppo è ancora ben lontana dall’essere la soluzione al problema della disinformazione online.