Disinformazione, Intelligenza Artificiale ed elezioni UE: che cosa aspettarsi?

Prebunking della disinformazione generata da intelligenza artificiale in vista del voto europeo

Questo articolo è la traduzione in italiano dell’originale qui consultabile, pubblicato sulla pagina web della Taskforce EDMO per le Elezioni europee del 2024

I cittadini europei di 27 diversi Stati membri voteranno per le prossime elezioni per il Parlamento europeo tra il 6 e il 9 giugno. L’attuale legislatura è stata caratterizzata da sfide enormi e senza precedenti per l’Unione, dalla pandemia di Covid-19 fino all’invasione russa dell’Ucraina, che hanno lasciato ferite profonde nelle società europee. La disinformazione – secondo un recente sondaggio globale dell’UNESCO l’85% delle persone è preoccupato dal suo impatto e l’87% ritiene che abbia già fatto danno alle politiche del proprio Paese – incombe sul voto, pronta a sfruttare le fratture e gli sconvolgimenti interni agli Stati europei, per polarizzare il dibattito e potenzialmente per portare avanti gli interessi di diversi attori, nazionali o stranieri che siano.

La capacità dell’Intelligenza Artificiale (IA) di generare contenuti che possono essere usati per promuovere la disinformazione è, secondo ricerche accademiche e diversi esperti, uno degli sviluppi più preoccupanti in questo ambito negli ultimi anni. A marzo 2023 il Parlamento europeo ha adottato lo AI Act, che regolamenta nel complesso l’IA, ma le sue norme non saranno applicabili in tempo per le elezioni europee di giugno 2024. Altri strumenti normativi dell’UE – in particolare il DSA e il DMA – potrebbero avere un ruolo nel prevenire il dilagare di questo genere di disinformazione, ma si tratta di una legislazione nel complesso nuova e ancora non sperimentata.

Finora la disinformazione generata da IA rappresenta una piccola percentuale del totale della disinformazione rilevata nell’UE, in base ai brief mensili dell’EDMO fact-checking network, ma alcuni casi rilevanti sono circolati negli scorsi mesi e settimane e sono stati verificati da organizzazioni di fact-checking.

Prendendo in esame quattro categorie di contenuti – immagini, audio, video e testi generati da IA – e guardando ai casi recenti (molti dei quali elencati in un rapporto della Taskforce EDMO sulle elezioni UE e nei già citati brief mensili di EDMO), che cosa ci si può ragionevolmente aspettare accada in vista delle prossime elezioni europee?

Immagini generate dall’IA

Negli ultimi mesi diverse immagini generate dall’intelligenza artificiale sono state diffuse in vari paesi dell’UE per diffondere disinformazione. Ad esempio è circolata un’immagine di trattori e balle di fieno davanti alla Torre Eiffel a Parigi, per esagerare la dimensione delle proteste dei trattori; un’immagine di Frans Timmermans (ex vicepresidente della Commissione europea e candidato per l’alleanza GroenLinks-PvdA alle elezioni olandesi del 2023) a bordo di un jet privato per Málaga, con un pasto delizioso sul tavolo, è stata diffusa con una didascalia che lo accusava di immoralità; un’immagine di Donald Trump con Jeffrey Epstein è stata creata per screditare l’ex presidente americano; in Irlanda è poi girata l’immagine di una madre bianca con bambini costretta a vivere di elemosina in una tenda, diffusa per suscitare animosità contro i migranti nel contesto della crisi degli alloggi in corso nel Paese; un’immagine in cui l’intero pavimento di una stanza è ricoperto di cartoni della pizza, spesso pieni, è stata diffusa per tacciare il Partito Verde tedesco di ipocrisia, e così via.

In tutti questi casi è evidente che le immagini non sono reali ma sono state create con l’IA. Lo si capisce dai dettagli delle immagini stesse: le mani, le dita, gli occhi, le forme, le ombre, i dettagli dello sfondo contengono spesso errori o sono comunque chiaramente irrealistici. Questa relativa facilità nell’individuare le immagini generate dall’intelligenza artificiale non solo per gli esperti, ma anche per gli utenti, è uno dei motivi più probabili per cui l’uso di questa tecnologia per produrre disinformazione è ancora limitato. Nelle crisi recenti, come ad esempio il conflitto Israele/Hamas, chi voleva fare disinformazione ha usato molto più spesso immagini reali ma vecchie o fuori contesto, accompagnandole con didascalie fuorvianti che inducono gli utenti a credere ritraggano invece eventi attuali, che non immagini generate dall’intelligenza artificiale.

Considerando i precedenti e l’attuale capacità dell’IA di generare immagini realistiche, è possibile prevedere un utilizzo limitato o non particolarmente impattante di questo tipo di contenuti per diffondere disinformazione in vista delle elezioni europee. Ovviamente è possibile aspettarsi che verranno create immagini con l’IA per promuovere diverse narrazioni di disinformazione, ad esempio che le elezioni sono truccate, le schede elettorali manomesse, alle elezioni prendono parte migranti illegali e via dicendo; o immagini di personaggi politici che fanno cose che non hanno mai fatto, allo scopo di attaccarli; o, ancora, immagini per trasmettere messaggi fortemente emotivi su argomenti rilevanti del dibattito politico (si pensi al caso citato dell’Irlanda), e così via.

Tuttavia, la qualità delle immagini generate con l’IA dovrebbe consentire anche agli utenti non esperti di verificare velocemente che si tratta di contenuti non reali. In considerazione di ciò, è anche possibile aspettarsi che la quantità di immagini generate dall’intelligenza artificiale che promuovono la disinformazione non crescerà prima delle elezioni in modo significativamente superiore alle percentuali osservate nei mesi precedenti. È probabile che la tecnica di mettere in circolazione immagini reali ma vecchie o fuori contesto, con didascalie fuorvianti, sarà utilizzata maggiormente nella diffusione di disinformazione prima del voto UE. Ovviamente questo scenario può sempre cambiare rapidamente, qualora l’evoluzione della tecnologia rendesse più difficile distinguere le immagini create dall’IA da quelle reali.

Audio generati dall’IA

Se si guarda ai casi recenti, gli audio sono lo strumento di possibile disinformazione generata con l’IA che desta maggiori preoccupazioni. La tecnologia disponibile al momento è già in grado di creare contenuti che sono difficili da individuare per l’utente medio come generati dall’intelligenza artificiale. Sono poi privi dell’elemento visivo, che spesso fornisce suggerimenti cruciali per riconoscere immediatamente l’origine artificiale del contenuto, e anche i tool per rilevare l’uso dell’intelligenza artificiale al momento non sembrano essere all’altezza.

Un esempio, in particolare, mostra come questa tecnica di disinformazione possa essere estremamente pericolosa a ridosso delle elezioni. In Slovacchia, appena due giorni prima delle elezioni parlamentari di settembre 2023, migliaia di utenti dei social network hanno condiviso un file audio sospetto, presentato come una conversazione tra Michal Šimečka, presidente di Progresívne Slovakia (PS), e la giornalista Monika Tódová. Nell’audio – un falso generato con l’IA – i due discutevano di come manipolare le elezioni a favore del PS, anche comprando voti dalla comunità rom.

La qualità dell’audio era relativamente scarsa, quindi diversi esperti hanno potuto stabilire senza particolari problemi che si trattasse di un contenuto generato con l’IA. Tuttavia, l’audio è diventato virale durante il silenzio elettorale, e questo ha reso quasi certamente meno efficaci le reazioni da parte delle vittime della disinformazione, volte a ristabilire la verità.

Šimečka tra l’altro era già stato preso di mira da una manipolazione simile solo pochi giorni prima: sui social network erano infatti apparsi diversi post con un’altra presunta registrazione audio, in cui il politico slovacco discuteva di (inesistenti) piani del partito per aumentare drasticamente il prezzo della birra dopo le elezioni. La qualità dell’audio, ancora una volta, è stata sufficientemente scarsa da consentire agli esperti (anche usando alcuni tool) di valutare rapidamente l’origine artificiale del contenuto. Ma nel frattempo, a pochi giorni dal voto, anche in questo caso il falso audio è circolato viralmente.

Un altro esempio rilevante che si può citare è l’audio generato dall’intelligenza artificiale del presidente degli Stati Uniti Joe Biden: due giorni prima delle primarie democratiche del New Hampshire, nel gennaio 2024, migliaia di persone nello Stato hanno ricevuto una “robocall” (un tipo di chiamata che invia messaggi pre-registrati a grandi quantità di persone) generata dall’intelligenza artificiale. Una voce che somigliava molto a quella di Joe Biden invitava la gente a non votare alle primarie.

Si può poi citare come esempio anche il falso audio della madre di Alexei Navalny che accusa la moglie, Yulia Navalnaya, di essere un’opportunista senza cuore, e di essere sostanzialmente responsabile della morte di suo figlio.

Se si guarda a questi e ad altri simili precedenti si può ritenere probabile che contenuti audio generati dall’IA appaiano prima delle prossime elezioni europee, almeno in alcuni Paesi, per diffondere disinformazione. Tali audio potrebbero essere utilizzati per screditare i politici, promuovere teorie del complotto sulla correttezza del processo elettorale e/o scoraggiare la partecipazione democratica. La quantità di questo genere di contenuti non sarà probabilmente molto elevata, considerando che in molti Paesi dell’UE la disinformazione rilevata finora non è ancora fortemente caratterizzata da questa tecnologia, e la qualità non dovrebbe essere ancora sufficientemente elevata da impedire agli esperti di individuarne l’origine artificiale. È probabile però che gli utenti meno esperti possano essere ingannati con contenuti audio generati dall’IA. Se ciò dovesse avvenire a ridosso del voto, ci sarebbe il concreto rischio che il fact-checking non riesca a raggiungere in tempo tutti i cittadini che hanno ascoltato, magari prendendolo per vero, il falso contenuto audio.

Infine vale la pena segnalare un rischio speculare: la delegittimazione di un audio genuino che a ridosso del voto informi l’opinione pubblica di fatti realmente accaduti (ad esempio una dichiarazione a microfono spento problematica o imbarazzante da parte di un candidato) da parte del protagonista della registrazione, tramite l’accusa che si tratti di un contenuto falso generato con l’IA. Se il tempo necessario per smentire tali accuse fosse superiore a quello mancante al voto, chi ha fatto disinformazione sull’audio potrebbe trarre vantaggio dalla confusione creata. Per inciso, è importante ricordare sempre che l’obiettivo principale della disinformazione non è convincere le persone della falsità che diffonde, ma far passare il messaggio che è impossibile distinguere ciò che è vero da ciò che è falso, e che tutte le versioni dei fatti hanno uguale dignità.

Video generati dall’IA

La tecnologia per generare video con l’intelligenza artificiale si sta evolvendo rapidamente. Nelle scorse settimane diversi video creati dall’IA, a partire da un testo, sono stati condivisi online, rendendo palese quanto sia difficile per un utente medio identificare il contenuto come artificiale e non reale. Lo strumento più avanzato di questo tipo è forse Sora di OpenAI, la società che ha creato ChatGPT. Sora è stato presentato ufficialmente, mostrando le sue capacità nel generare video più realistici che mai, ma non è ancora disponibile al pubblico, probabilmente anche a causa delle preoccupazioni sui potenziali abusi, tra cui spicca la disinformazione.

La limitazione della diffusione delle tecnologie d’avanguardia è probabilmente uno dei principali motivi per cui i fact-checker in Europa non hanno ancora rilevato casi significativi di video di disinformazione interamente creati con l’IA: i video generati da testo disponibili non sono abbastanza realistici da poter essere scambiati per video reali. Pertanto, il rischio che contenuti video interamente generati con l’intelligenza artificiale circolino prima delle prossime elezioni europee con l’obiettivo di influenzarle al momento sembra basso.

Sarà invece molto più probabile individuare, prima del voto per il Parlamento europeo, contenuti di disinformazione in cui l’audio è generato o alterato dall’intelligenza artificiale, mentre il video è solo leggermente modificato per essere il più coerente possibile con l’audio. L’alterazione del video potrebbe infatti essere limitata alle labbra e alle espressioni facciali di chi parla, in modo che le parole e i movimenti di labbra e viso siano sincronizzati. La tecnologia per produrre questi effetti è già esistente, anche se non di rado imperfetta, e ampiamente utilizzata.

Negli ultimi mesi diverse organizzazioni dell’EDMO fact-checking network hanno rilevato contenuti di questo tipo. Ad esempio una trasmissione di France24 è stata manipolata, mettendo in bocca a uno dei suoi giornalisti parole che non aveva mai pronunciato attraverso l’uso della sincronizzazione labiale. In particolare, nel video manipolato, il giornalista afferma che il presidente francese Emmanuel Macron sarebbe stato costretto a cancellare la sua visita in Ucraina per timore di un attentato. Un video della BBC in cui compare Greta Thunberg è stato modificato per farle dire che gli esseri umani dovrebbero optare per “carri armati e armi ecologicamente sostenibili” se vogliono continuare a combattere le guerre. Un video dell’attore ceco Ondřej Vetchý, promotore di una raccolta fondi con l’obiettivo di finanziare l’acquisto di droni da parte dell’Ucraina, è stato manipolato per fargli affermare che anche i cechi dovrebbero adorare Stepan Bandera (politico nazionalista ucraino di estrema destra che collaborò con i nazisti durante la Seconda Guerra Mondiale). Un video dell’ex capo delle forze armate ucraine, il generale Valery Zaluzhny, è stato falsificato per fargli accusare il presidente Zelenskyj di essere un traditore e invitare gli ucraini a ribellarsi contro il suo governo. Molti altri casi accertati, spesso incentrati su politici (ad esempio Meloni, Babis, Denkov), erano poi truffe online.

Testi generati dall’IA

I testi generati dall’intelligenza artificiale pongono due diversi ordini di problemi. Da un lato, se il testo viene generato su richiesta di un utente che poi non lo diffonde pubblicamente, c’è il rischio – particolarmente significativo per quei Large Language Models (LLM) che non dispongono di forti meccanismi di protezione e/o si basano su dataset controversi – che le informazioni fornite siano errate o fuorvianti e l’utente, che è stato esposto a tali falsità, non lo venga mai a sapere. I soggetti esterni (organizzazioni di fact-checking, gli esperti e così via) non avendo accesso a questo contenuto non possono infatti nemmeno verificarlo. Come ha sottolineato EDMO in un articolo dedicato al tema, esiste insomma il rischio che gli utenti credano che le risposte che ricevono dei chatbot basati su LLM siano quelle più corrette possibili e non solo risposte convincenti.

Dall’altro lato, se i testi generati dall’intelligenza artificiale vengono resi disponibili pubblicamente – ad esempio se gli utenti privati condividono online i risultati delle loro richieste ai LLM, ma esistono addirittura siti web di notizie interamente scritte da IA -, la disinformazione non fluirà in modo diverso da quanto faccia quando le notizie false testuali vengono generate dagli esseri umani. L’aspetto più problematico in questo caso è il volume: l’intelligenza artificiale permette teoricamente di creare enormi quantità di disinformazione testuale con un costo contenuto e in tempi brevissimi. Ma anche il volume da solo non basta. È la possibilità di automatizzare con l’IA non solo la creazione ma anche la distribuzione e l’amplificazione di contenuti testuali di disinformazione, che rischia di inquinare significativamente il discorso pubblico.

Che ci siano tentativi che vanno in questa direzione prima del voto europeo di giugno è possibile, se non probabile. Ma in teoria le piattaforme social, che hanno policy molto severe su inauthentic behavior e campagne coordinate (es. Meta, X, TikTok), dovrebbero avere gli strumenti e le capacità per individuare e bloccare rapidamente questo genere di operazioni, riducendone l’impatto.

In conclusione

I contenuti generati dall’intelligenza artificiale utilizzati per diffondere disinformazione rappresentano un rischio significativo in vista delle elezioni europee di giugno 2024. Possono essere utilizzati per screditare politici e/o altri personaggi pubblici, per diffondere false accuse e teorie del complotto e, in generale, per attaccare l’integrità del processo democratico.

Le immagini generate dall’intelligenza artificiale sembrano rappresentare un rischio medio, considerando la loro qualità attuale. I video generati dall’intelligenza artificiale sono potenzialmente dannosi, in particolare quelli in cui il video è reale e l’audio è invece alterato dall’intelligenza artificiale, ma per ora verificarne l’autenticità è relativamente facile. I testi generati dall’intelligenza artificiale rappresentano attualmente un rischio relativamente basso, ma è importante reagire in modo rapido ed efficace per fermare qualsiasi campagna di disinformazione volta a sfruttare il volume potenzialmente enorme di disinformazione che può essere creato in questo modo. Gli audio generati dall’intelligenza artificiale, infine, sembrano rappresentare il rischio maggiore: sono più difficili da verificare e possono ingannare più facilmente gli utenti.

La prima e più importante linea di difesa, come spesso accade, è la consapevolezza del problema da parte dei cittadini: di fronte a contenuti che trasmettono un messaggio fortemente emotivo, che possono incidere sulla decisione di votare o meno, e per chi, e che non trovano conferma nei media tradizionali, nutrire un sano scetticismo, controllare i dettagli e attendere ulteriori conferme prima di condividerli sono buone pratiche che possono ridurre significativamente la diffusione della disinformazione.

Tommaso Canetta, vicedirettore di Pagella Politica/Facta News e coordinatore delle attività di fact-checking di EDMO

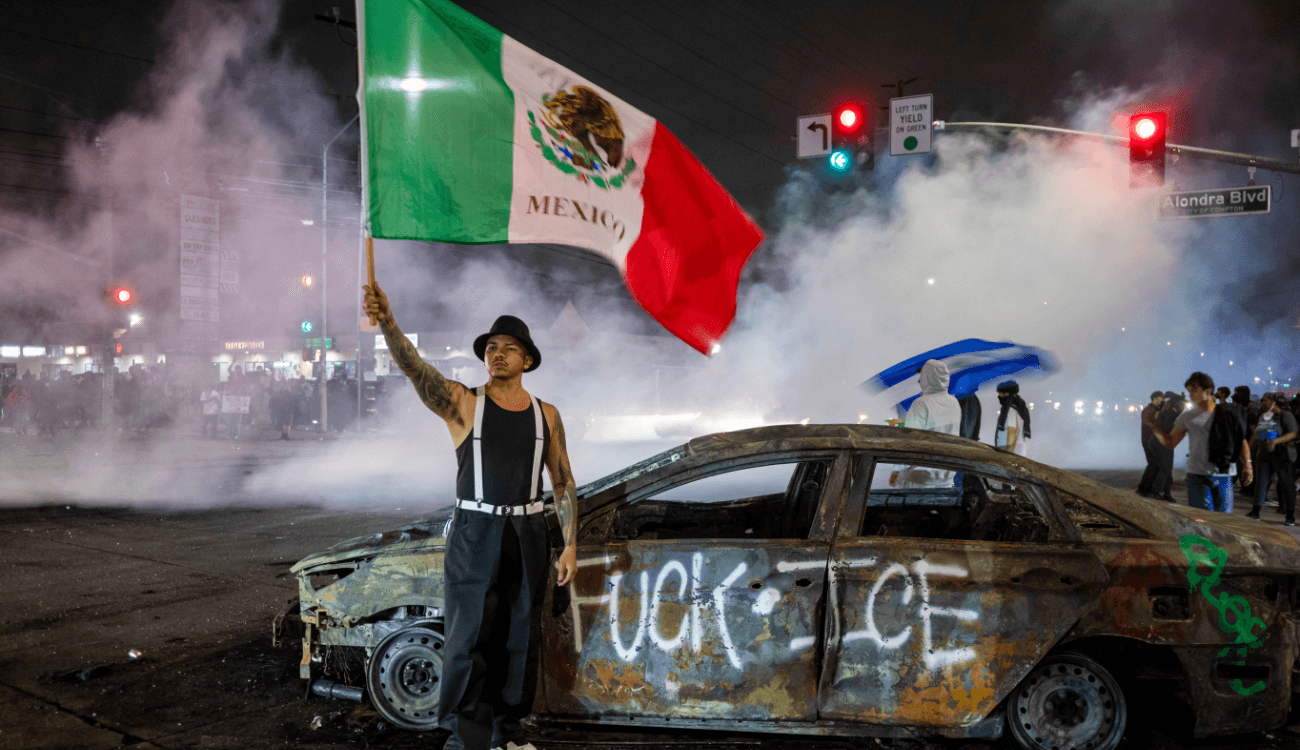

- Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking

Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking

Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking - La storia di Djokovic che dà un assegno al bidello di 79 anni è inventataLa storia di Djokovic che dà un assegno al bidello di 79 anni è inventata