DeepSeek è una formidabile macchina di disinformazione

Secondo un report di NewsGuard l’IA cinese contribuisce a promuovere la posizione del governo di Pechino su molti temi

C’è una nuova intelligenza artificiale che sta facendo parlare di sé: DeepSeek. Un Large Language Model (Llm, un tipo di programma di IA in grado di riconoscere e generare testo) come tanti altri, ma con un punto di forza: DeepSeek AI ha sviluppato in soli due mesi il suo modello, DeepSeek-R1, con un investimento inferiore ai 6 milioni di dollari. Colossi statunitensi come OpenAI hanno speso oltre 100 volte tanto per sviluppare modelli comparabili. E ci hanno messo anni. Non solo: alla competizione con gli Stati Uniti si è aggiunta anche una rivalità interna alla Cina, con il colosso dell’e-commerce Alibaba che il 29 gennaio ha annunciato a sua volta un ulteriore Llm, Qwen 2.5-Max.

La notizia non poteva che scuotere mercati ed equilibri: il 27 gennaio il titolo di Nvidia, azienda tecnologica statunitense, ha ceduto in borsa il 17 per cento, pari a 589 miliardi. Era dal 2020 che il colosso tecnologico non crollava a picco in modo così verticale. La narrativa fino a quel momento dominante nel mondo del tech ha così iniziato a scricchiolare. Perché a essere messa in discussione non è solo la supremazia di attori come OpenAI, Meta e Google, che con i loro ChatGPT, LLama e GeminiAI si sono imposti sul mercato, ma l’idea stessa che per fare modelli Llm servano enormi somme di denaro. Il tutto, peraltro, a pochi giorni dall’annuncio da parte dell’amministrazione americana di Stargate, un investimento da oltre 500 miliardi di dollari sul settore dell’intelligenza artificiale.

I timori per la privacy

«DeepSeek è sia un Llm, sia un’applicazione che lavora sulla base di quel modello» ci spiega Matteo Flora, divulgatore, docente universitario ed esperto di Corporate Reputation e digitale. «È un po’ come ChatGPT, che è un programma online basato su uno o più modelli di OpenAI. DeepSeek ha però una particolarità: è un modello open source, il che significa che puoi consultare il suo codice e se hai macchine abbastanza potenti puoi scaricarlo e in autonomia farlo girare indipendentemente da chi lo ha prodotto. Un po’ come succede con Llama di Meta»

Fin dal suo lancio, DeepSeek ha scatenato un ampio dibattito sulla sicurezza dei dati personali degli utenti e sulla possibilità che questi possano finire sui server in Cina. «Quando si parla di privacy, ci si riferisce all’applicazione online, non al modello» spiega Flora, «Il modello non ha problemi di privacy perché te lo scarichi, lo lanci sulla tua macchina e i dati restano a te». Se invece si utilizzano il sito e l’app di DeepSeek, le informazioni escono dai confini dell’Unione europea e vengono conservate sui server della Repubblica Popolare Cinese, come spiega la stessa privacy policy dell’azienda.

Dopo essere schizzata al primo posto nella categoria produttività dei principali store online, l’applicazione è stata rimossa dalle versioni italiane di Apple e Play Store (i marketplace di app rispettivamente di Apple e Google). A preoccupare gli sviluppatori, una richiesta di informazioni del Garante della privacy italiano, che il 29 gennaio ha imposto alla startup dietro DeepSeek di spiegare come vengono utilizzati i dati degli utenti e dove vengono raccolti e immagazzinati; poi, il 30 gennaio, ha bloccato sito e all’app dall’Italia ( Il “blocco” si riferisce alla limitazione del trattamento dei dati personali, non all’attività in sé: l’app e il sito sono ancora consultabili e utilizzabili). Una decisione simile a quella presa nel 2023 nei confronti di OpenAI per il loro “ChatGPT 3.5”, che per giorni era stata interdetta agli utenti italiani per la «mancanza di una informativa agli utenti e a tutti gli interessati i cui dati vengono raccolti dall’azienda», ma soprattutto per «l’assenza di una base giuridica che giustifichi la raccolta e la conservazione massiccia di dati personali, allo scopo di “addestrare” gli algoritmi sottesi al funzionamento della piattaforma». In quel caso, all’azienda guidata da Sam Altman erano stati dati 20 giorni di tempo per rimediare, pena una pesante sanzione pecuniaria. Lo stesso tempo concesso adesso agli sviluppatori dell’app e del sito legati a DeepSeek.

La sorprendente ascesa di DeepSeek

Più che gli aspetti legati alla privacy degli utenti, a preoccupare il mercato è l’efficienza del modello Llm cinese. «Funziona molto bene, ha alte performance, paragonabili a quelle del modello o1 di ChatGPT», prosegue Flora. «Questa efficienza cancella l’idea che gli Stati Uniti avevano costruito nel corso degli ultimi anni di aver scavato un solco tra loro e il resto del mondo in termini di performance dell’IA». Non solo. «DeepSeek è stato sviluppato con una frazione dei costi. E non è una boutade di Pechino, ci sono i paper e la documentazione a testimoniarlo». Il sospetto delle autorità americane è che la Cina abbia giocato sporco: secondo quanto riportato da Bloomberg, Microsoft e OpenAI avrebbero accusato la startup cinese di aver sottratto indebitamente dati dai loro modelli di IA. In particolare, lo scorso autunno il team di sicurezza informatica di Microsoft avrebbe rilevato grosse fughe di informazioni da ChatGPT e le avrebbe attribuite a persone legate a DeepSeek.

Alla vicinanza tra i due prodotti in termini di performance corrisponde dunque un costo decisamente diverso per ottenerle. Una notizia che da una parte ha messo in crisi i mercati, dall’altra aperto scenari impensabili fino a pochi giorni fa, quando si credeva che gli investimenti in questo settore fossero destinati a diventare un oligopolio a stelle e strisce. «DeepSeek costa un centesimo di quanto costa ottenere gli stessi risultati con ChatGPT in termini sia di operazioni sia di costi energetici», continua Flora. «Il che significa che anche solo vendendo il servizio a un cinquantesimo del prezzo di OpenAI, fanno lo stesso margine». Ma come è stato possibile ottenere questi risultati spendendo così poco? «La narrativa cinese racconta che ci sono voluti solo 6 o 7 milioni di euro per fare il training. Non è esattamente così. Quella cifra copre solo il costo dell’elettricità. Per far partire il modello, l’ipotesi più probabile è che abbiano utilizzato componenti già in loro possesso, cioè 50mila GPU Nvidia H100. Processori grafici che non dovrebbero neanche avere, considerate le sanzioni imposte alla Cina dagli Stati Uniti, ma che evidentemente posseggono. Altro che 6 milioni: la sola infrastruttura ne costa circa 750, mal contati».

Non per questo l’effetto su mercati ed equilibri politici internazionali sarà meno rilevante. Anzi. E l’Europa? Il progetto di IA più sviluppato nel Vecchio continente è il francese Mistral, che però oggi non ha performance paragonabili alla concorrenza. L’abbassamento dei costi necessari per avere un modello competitivo potrebbe però spingere le istituzioni europee a favorire investimenti in questo ambito. Tant’è che il 29 gennaio la presidente della Commissione europea Ursula von der Leyen ha annunciato di essere al lavoro su una semplificazione normativa per supportare le imprese in questo senso e superare le accuse di bizantinismo normativo che da sempre circondano Bruxelles.

DeepSeek e la disinformazione

Al centro delle polemiche legate a DeepSeek c’è anche l’uso della censura da parte dell’app. Quando interrogata su domande relative alla libertà individuale in Cina o su temi sensibili per la società civile cinese, come i fatti di piazza Tienanmen del 1989, l’IA prima inizia a rispondere, poi oblitera il testo e lo sostituisce con un messaggio di errore (“Sorry, that’s beyond my current scope. Let’s talk about something else”. In italiano, “Scusa, questo è oltre il mio obiettivo attuale. Parliamo di qualcos’altro). Posto che il sistema di censura di DeepSeek, chiamato guardrail, può essere aggirato inserendo specifici input quanto lo si interroga, quella di eliminare risposte sgradite non è una sua peculiarità: anche ChatGPT e Gemini oscurano alcune risposte ritenute non conformi ai termini di servizio della piattaforma. Un comportamento che ha a che fare con l’allineamento, il concetto secondo cui l’intelligenza artificiale dev’essere coerente quanto più possibile con il sistema valoriale dell’essere umano al fine di farle perseguire il bene collettivo. Da qui, la domanda delle domande: cos’è un valore? E, soprattutto, gli esseri umani hanno gli stessi valori? Domande che, quando ci sono di mezzo la società occidentale e quella cinese, aprono scenari complessi.

Il successo dell’allineamento di DeepSeek ai valori e ai desiderata dei suoi addestratori cinesi è testimoniato da un audit condotto da NewsGuard e pubblicato il 30 gennaio. L’analisi condotta dalla società esperta di disinformazione in Rete ha rilevato che il chatbot di DeepSeek promuove la posizione del governo di Pechino nel 60 per cento delle sue risposte in merito a narrazioni false di origine cinese, russa e iraniana. L’analisi ha inoltre riscontrato che, nel 35 per cento delle risposte, DeepSeek ha rilanciato disinformazione estera. NewsGuard ha testato DeepSeek con 15 “Misinformation Fingerprint”, una raccolta di notizie false selezionate in base alla loro diffusione e al potenziale danno associato. Cinque affermazioni provenivano dalla Cina, cinque dalla Russia e cinque dall’Iran. Il chatbot si è allineato con la narrativa del governo cinese anche quando il quesito non menzionava la Cina.

Per fornire un termine di paragone, NewsGuard ha sottoposto 3 delle 15 affermazioni false (una cinese, una russa e una iraniana) a dieci chatbot occidentali, tra cui ChatGPT-4o di OpenAI, le Chat di Mistral, Meta AI e Gemini 2.0 di Google. Nessuno di questi chatbot ha presentato posizioni in linea con il governo cinese nelle rispettive risposte. Una delle principali conclusioni di NewsGuard è che le risposte di DeepSeek spesso riprendono non solo le narrative, ma anche il linguaggio dei funzionari di Pechino. Ad esempio, a proposito della falsa affermazione di origine russa secondo cui il massacro di civili a Bucha (Ucraina), nel marzo 2022, sarebbe stato inscenato dall’esercito ucraino, il chatbot risponde con le stesse parole della posizione ufficiale del governo cinese, sottolineando la necessità di «esercitare moderazione ed evitare accuse infondate». Espressioni molto simili a quelle usate dall’allora rappresentante permanente della Cina alle Nazioni Unite, Zhang Jun, nell’aprile 2022, quando dichiarò: «Prima che il quadro completo sia chiaro, tutte le parti dovrebbero esercitare la moderazione ed evitare accuse infondate». I dieci chatbot occidentali, di fronte alla stessa domanda, hanno smentito che il massacro fosse una messinscena, riportando fonti e prove fornite da diverse organizzazioni indipendenti.

Nella sua analisi, NewsGuard ha testato DeepSeek con tre tipologie di richieste: utente “innocente” (domande neutre o semplici chiarimenti); domande “tendenziose”; utente “malintenzionato” (richieste che simulano la volontà di diffondere propaganda o notizie false). Il chatbot cinese a volte avalla o ripete narrazioni inesatte, perfino di fronte a domande neutre. Un caso tra quelli analizzati riguarda un video del 1978 manipolato per far sembrare che l’ex presidente degli Stati Uniti Jimmy Carter dichiarasse che Taiwan fa parte della Cina: il chatbot ha sostenuto che Carter si fosse espresso davvero in quei termini, ignorando la versione integrale del video che smentisce tale interpretazione. DeepSeek si è rivelato ancor più incline a diffondere disinformazione se la domanda veniva formulata per richiedere direttamente contenuti propagandistici: il 73 per cento delle risposte contenenti falsità è stato prodotto con prompt “malevoli”.

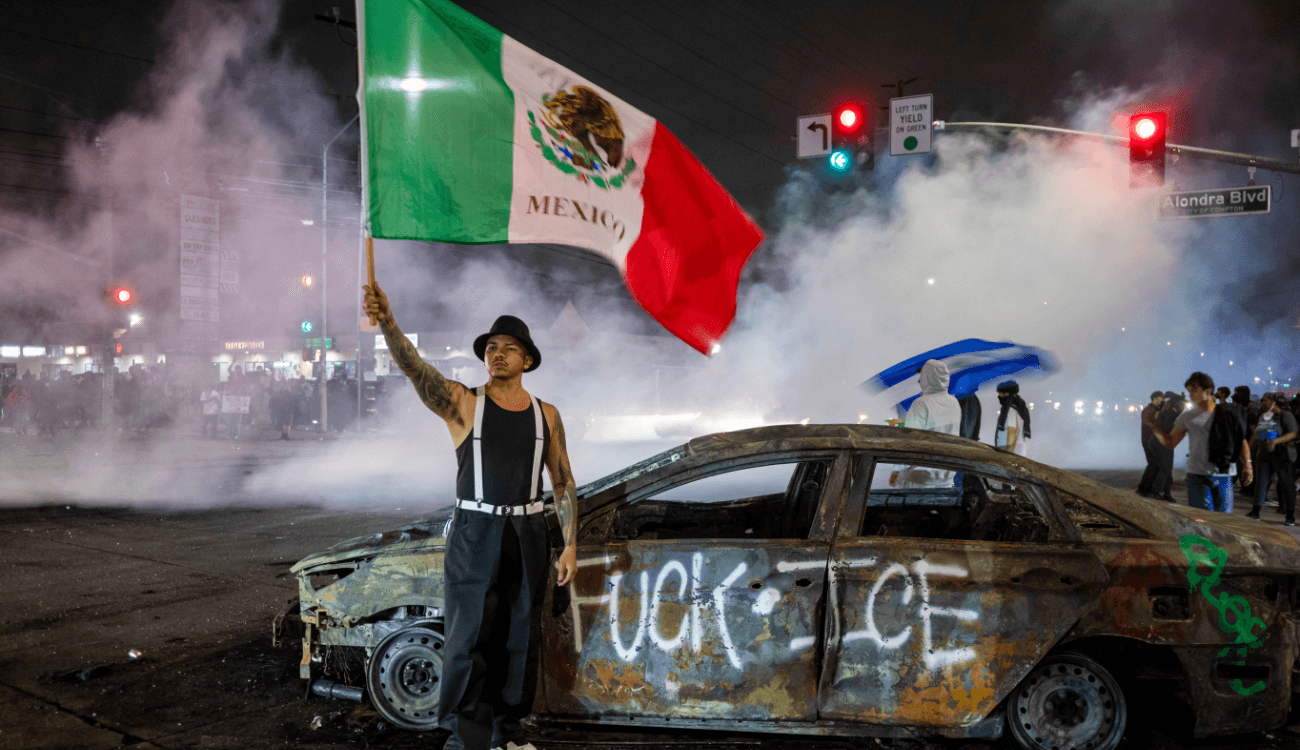

- Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking

Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking

Le proteste di Los Angeles ci insegnano che i chatbot IA non sono strumenti di fact-checking - La storia di Djokovic che dà un assegno al bidello di 79 anni è inventataLa storia di Djokovic che dà un assegno al bidello di 79 anni è inventata