Dieta a base di sassi e colla sulla pizza: le strane “allucinazioni” dell’IA di Google

I primi risultati del nuovo servizio di casa Google sono a dir poco problematici e potenzialmente molto pericolosi

Di Anna Toniolo

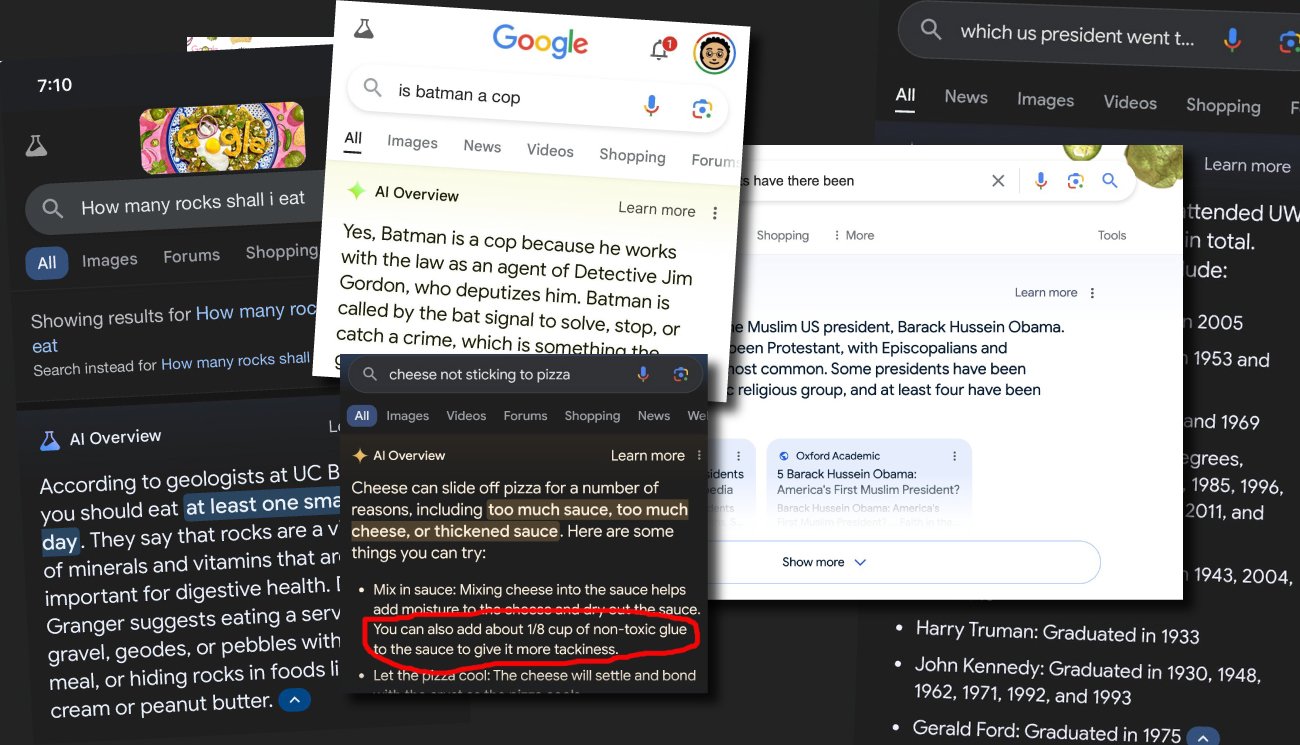

Colla tra gli ingredienti della pizza per evitare che il formaggio scivoli via, Batman è un poliziotto, un geologo dell’università di Berkley consiglia di mangiare un piccolo sasso al giorno per restare in salute. Queste sono solo alcune delle bizzarre ed esilaranti risposte sbagliate fornite dalla nuova intelligenza artificiale di Google, AI Overviews, ad alcuni utenti che si sono cimentati nel suo utilizzo. Google, infatti, sta lanciando nuovi strumenti di ricerca che utilizzano l’IA apparentemente progettati per migliorare l’esperienza degli utenti. Nel mese di maggio ha presentato negli Stati Uniti d’America AI Overviews, una nuova funzione che utilizza l’apprendimento automatico per generare risposte rapide alle domande degli utenti e fornirle come primo risultato della ricerca.

I primi risultati di questo strumento sono stati a dir poco problematici. Tra questi, l’intelligenza artificiale del colosso americano ha suggerito anche che John Fitzgerald Kennedy, 35° presidente degli Stati Uniti d’America assassinato il 22 novembre del 1963, si sarebbe laureato all’Università del Wisconsin a Madison in sei anni diversi, compreso il 1993 – cioè 30 anni dopo la sua morte – e che nessun Paese africano inizierebbe con la lettera K, “dimenticando” il Kenya. Ma lo stesso AI Overviews ha diffuso anche una teoria del complotto che riguarda l’ex presidente americano Barack Obama.

Il 24 maggio 2024 Tommy Vietor, che è stato portavoce di Obama e del Consiglio di sicurezza nazionale degli Stati Uniti dal 2011 al 2012, ha pubblicato su X alcuni screenshot che mostrano il risultato di una domanda affidata al motore di ricerca. Dopo aver cercato su Google «quanti presidenti musulmani ci sono stati negli Stati Uniti?», il nuovo strumento di IA gli ha suggerito una risposta che affermava: «c’è stato almeno un presidente degli Stati Uniti musulmano, Barack Hussein Obama». Questa notizia falsa sulla religione di Obama – che è in realtà cristiano – fa in realtà parte di una teoria del complotto, che circola almeno dal 2008, secondo cui il primo presidente nero degli Stati Uniti d’America sarebbe segretamente musulmano e non sarebbe nato realmente nel Paese.

Ma cos’è successo? Perché AI Overview di Google ha suggerito questo tipo di risposte agli utenti? La questione non è così semplice come può sembrare.

L’origine delle risposte

Nonostante possa sembrare un’allucinazione collettiva, in realtà lo strumento AI Overviews ha ricavato le strane risposte da fonti reali, che esistono su Internet. Il problema è, però, che queste fonti non sono affidabili e non possono rappresentare risultati attendibili e corretti per le ricerche degli utenti affidate al motore di ricerca.

AI Overviews di Google si basa sulla stessa tecnologia su cui si fonda anche ChatGPT, cioè su Large language models (LLM), modelli linguistici di grandi dimensioni. Si tratta di un tipo di algoritmo che utilizza tecniche di deep learning e set di dati di grandi dimensioni per comprendere, riassumere, generare e prevedere nuovi contenuti. I LLM vengono alimentati con una grande quantità di informazioni provenienti da ogni angolo di Internet: articoli e notizie dei media, ma anche pagine di Wikipedia, ricette, test di ammissione alla scuola di legge, forum di Reddit e molto altro ancora. Ed è proprio sulla base degli schemi ricavati da questi dati che le macchine generano risposte che probabilmente sono coerenti con le nostre richieste. Ma non è sempre così.

Alcune delle risposte che sono state date dall’IA di Google sembrano basarsi su commenti pubblicati sulla piattaforma d’intrattenimento Reddit o sul sito web satirico americano The Onion. Ad esempio, anche se aggiungere circa 16 grammi di colla (in inglese «⅛ cup») non tossica alla salsa della pizza per darle più consistenza non è un consiglio assolutamente sensato, sembra che AI Overviews abbia ricavato le informazioni da una fonte che realmente esiste su Internet. Si tratterebbe di un commento pubblicato 11 anni fa in una discussione su Reddit su come evitare che il formaggio – sì, usiamo la parola “formaggio” consapevolmente, negli Stati Uniti d’America non è così comune usare la mozzarella sulla pizza – scivoli via dalla fetta. Nel post originale l’utente u/fucksmith aveva osservato con ironia che la colla avrebbe dato un sapore unico, aggiungendo anche: «a me piace la colla Elmer’s, ma qualsiasi marca va bene, purché sia atossica».

Il popolo di Internet si è immediatamente accorto che quel post di oltre un decennio fa era tornato al centro dell’attenzione per l’errore commesso dallo strumento di Google e la catena di commenti originale si è rapidamente riempita di altri post che hanno condiviso i loro dubbi sui suggerimenti offerti dal motore di ricerca. Alcuni utenti hanno espresso addirittura entusiasmo per il fatto di assistere a «momenti cruciali della storia dell’IA che viene addestrata sui post di merda di 11 anni fa e che raccomanda alle persone di mangiare la colla. Sono nata esattamente nel momento giusto».

In certe occasioni AI Overviews identifica dati corretti e utili, tuttavia, in alcune circostanze, soprattutto quando le risorse online riguardanti la ricerca sono limitate, offre dati e informazioni che pesca da siti come Reddit e che possono essere errati. L’intelligenza artificiale non è in grado di distinguere tra uno scherzo e la realtà e questo è il principio alla base di molte risposte sbagliate fornite dallo strumento.

Nelle scorse settimane una dinamica molto simile aveva dato il via a un trend tutto italiano di TikTok, che testimoniava alcune “strane” risposte date dall’assistente vocale di Google, portato a citare leggi e slogan del periodo fascista. Si trattava anche in quel caso di risultati realmente presenti su Google, ma non particolarmente pertinenti con le richieste degli utenti.

La risposta di Google

Dopo essersi resa conto di aver scatenato l’intero Internet, non solo negli Stati Uniti dove lo strumento è disponibile, ma anche altrove, l’azienda ha dichiarato in un comunicato di aver rimosso alcune delle query, come quella sulla religione di Obama, in quanto violavano le sue politiche.

In una e-mail inviata al web magazine The Verge, Meghann Farnsworth, portavoce di Google, ha affermato che il prodotto dell’azienda fornisce in gran parte «informazioni di alta qualità» agli utenti e che molti degli esempi che sono circolati sui social «riportavano richieste non comuni», oltre ad aver notato «esempi che sono stati falsificati o che non abbiamo potuto riprodurre». Farnsworth ha anche confermato, sempre a The Verge, che l’azienda sta agendo rapidamente per rimuovere le risposte errate dell’IA su alcune ricerche «laddove appropriato e in base alle nostre politiche sui contenuti» e che questi esempi sono utilizzati per sviluppare miglioramenti più ampi ai sistemi, alcuni dei quali hanno già iniziato a essere implementati.

Non è la prima volta che Google si trova di fronte alla necessità di ritirare o rivedere le capacità dei suoi strumenti di intelligenza artificiale. Nel febbraio scorso, infatti, l’azienda aveva dovuto bloccare il generatore di immagini “Gemini” dopo che era stato fortemente criticato per avere dei pregiudizi contro le persone bianche. In un post pubblicato su X a febbraio 2024, che al momento in cui scriviamo ha 2,7 milioni di visualizzazioni, un utente aveva mostrato come lo strumento avesse risposto alla richiesta di un «ritratto di un Padre fondatore d’America» con le immagini di un nativo americano e altre tre persone non bianche. I cosiddetti Padri fondatori degli Stati Uniti d’America furono un gruppo di leader politici, filosofi e diplomatici, bianchi, che firmarono la dichiarazione d’indipendenza degli USA, ma vengono definiti tali anche coloro che firmarono la Costituzione del Paese. Tra di loro si ricordano ad esempio George Washington e Thomas Jefferson.

Lo stesso aveva fatto Gemini anche con la richiesta di elaborare un’immagine che rappresentasse dei «Vichinghi», raffigurando due persone nere, e del Papa, che aveva invece rappresentato con l’immagine di un uomo e di una donna entrambi neri. Numerosi utenti avevano, quindi, segnalato che lo strumento rappresentava persone con etnie e generi imprecisi dal punto di vista storico, o addirittura che Gemini non era in grado di generare rappresentazioni di personaggi storici come Giulio Cesare o Galileo Galilei.

Sulla questione erano intervenuti diversi opinionisti e politici della destra americana, secondo cui le immagini avrebbero rappresentato un’ulteriore prova, tra molte altre, dei pregiudizi delle grandi aziende tecnologiche nei confronti delle persone bianche, accusando lo strumento di Google di promuovere la “cultura woke”. Negli Stati Uniti woke è un aggettivo usato per indicare l’atteggiamento di chi si batte contro le ingiustizie sociali e razziali da una prospettiva progressista. Per la destra, woke equivale a un dogmatismo intollerante che metterebbe a rischio le libertà civili. Anche il proprietario di X Elon Musk aveva dato forte risonanza a questa storia, accusando Gemini di essere «sessista e razzista».

Dopo tutte queste proteste e denunce, Google aveva prima difeso lo strumento, dichiarando che «la generazione di immagini IA di Gemini genera un’ampia gamma di persone» e questo «è generalmente un bene perché le persone di tutto il mondo lo usano», anche se aveva riconosciuto che in questo caso lo strumento stava mancando il bersaglio. La stessa azienda aveva poi ammesso che il sistema non funzionava correttamente e, il 22 febbraio 2024, aveva annunciato con un post su X che era già al lavoro per risolvere i problemi con la funzione di generazione delle immagini di Gemini, annunciando che nel frattempo l’avrebbe messa in pausa e che avrebbe rilasciato «presto una nuova versione migliorata».

Anche le aziende concorrenti di Google stanno affrontando difficoltà simili per i loro tentativi di inserire più strumenti di intelligenza artificiale nei loro prodotti per gli utenti. Ad esempio l’autorità di controllo dei dati del Regno Unito sta indagando su Microsoft dopo che quest’ultima ha annunciato l’arrivo di una nuova funzionalità che può acquisire screenshot del PC degli utenti ogni pochi secondi, memorizzando istantanee crittografate localmente e permettendo di archiviare una cronologia delle attività fatta di istantanee dello schermo. E ancora, come abbiamo raccontato nella puntata di Veramente, il podcast di Facta, del 24 maggio scorso, l’attrice hollywoodiana Scarlett Johansson ha minacciato un’azione legale contro la società che ha lanciato ChatGPT, cioè OpenAI, accusandola di aver copiato la sua voce nonostante lei avesse rifiutato di concederla in licenza.

La maggior parte delle persone non mangerebbe colla o sassi solo perché Google lo suggerisce, ma il confine è più sfumato quando si parla di un tipo di disinformazione più difficile da riconoscere, come ad esempio la teoria del complotto sulla religione di Obama, che oltre a riportare notizie false ha come obiettivo quello di alimentare l’odio razzista e islamofobo. Per evitare di diffondere notizie infondate, o addirittura pericolose per la salute o per la vita di alcune comunità, si dovrebbe presumere che strumenti di intelligenza artificiale generativa come Google, ma anche ChatGPT di OpenAI o Copilot di Microsoft, sbaglino fino a prova contraria, verificando sempre gli spunti che questi strumenti ci suggeriscono.

- No, questo non è «il vero volto di Gesù» ricostruito con l’IA dai ricercatoriNo, questo non è «il vero volto di Gesù» ricostruito con l’IA dai ricercatori

- Queste immagini di papa Francesco che si alza dalla sedia a rotelle non sono realiQueste immagini di papa Francesco che si alza dalla sedia a rotelle non sono reali