Proteggere le fonti con l’intelligenza artificiale ha anche i suoi rischi

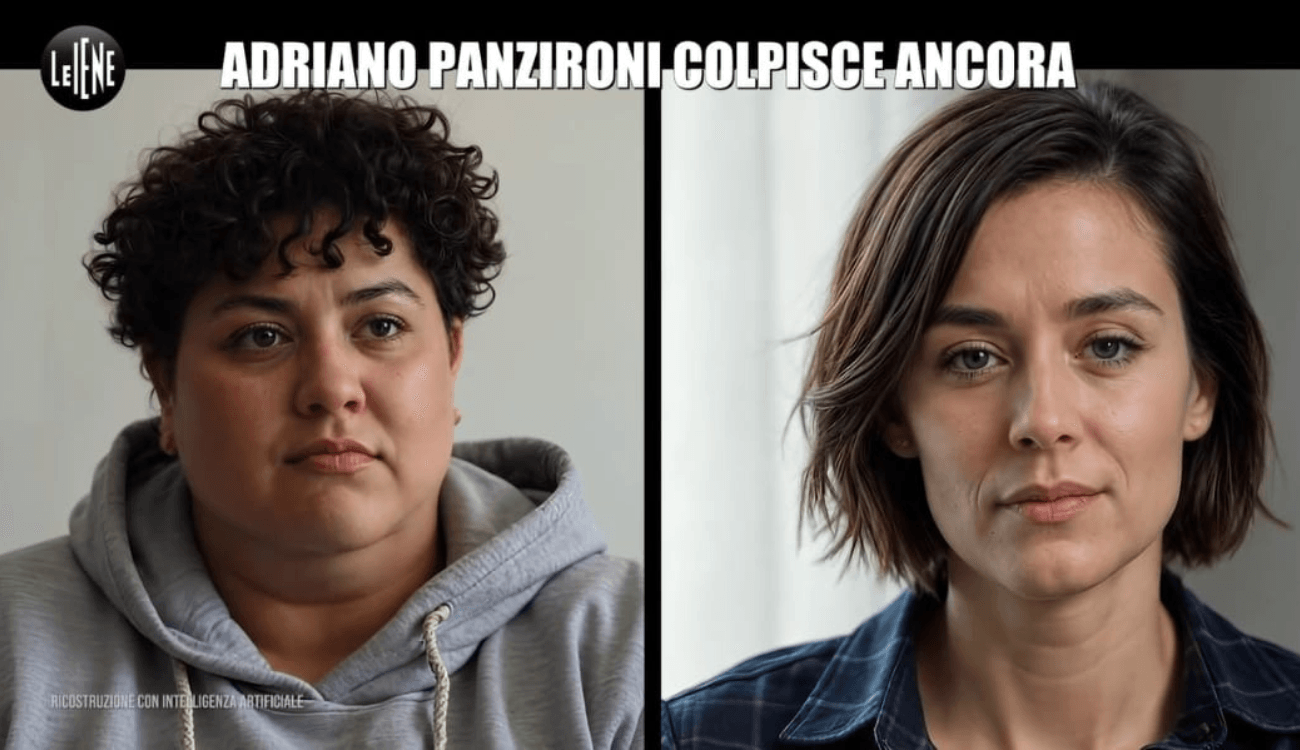

Il programma televisivo Le Iene ha sostituito per intero l’aspetto delle testimoni con due immagini generate dall’intelligenza artificiale

Lo scorso 24 novembre Le Iene hanno trasmesso un servizio particolare. Non nei contenuti, quanto piuttosto per come è stato realizzato. La trasmissione di Italia 1 ha raccontato di un nuovo presunto scandalo che riguarda Adriano Panzironi, un giornalista e imprenditore italiano noto per le sue posizioni controverse nel campo della salute e della nutrizione. Panzironi è diventato famoso per aver ideato e promosso il programma “Life 120”, un metodo senza alcuna validazione scientifica che promette di migliorare la salute delle persone e di estendere la loro vita fino a 120 anni. L’uomo è attualmente sotto processo per pratica abusiva della professione medica.

Secondo questo servizio, Panzironi si troverebbe al centro di una nuova bufera. In base alle testimonianze di due persone intervistate da Le Iene, nel 2023 l’imprenditore avrebbe costretto al licenziamento alcuni suoi dipendenti attuando dei finti trasferimenti: in pratica si propone al dipendente di spostarsi in una nuova sede, molto lontana, allo scopo di incentivare le dimissioni spontanee. Alcuni dei dipendenti costretti alle dimissioni in questo modo, però, non avrebbero mai ricevuto da Panzironi gli stipendi arretrati. Le due testimoni che muovono queste accuse a Panzironi sarebbero proprio due ex-dipendenti dei suoi negozi “Life 120”.

Quello che colpisce del servizio de Le Iene, però, è la modalità con cui è stata condotta l’intervista alle due ex-dipendenti delle aziende di Panzironi. Nel servizio le testimoni, identificate con gli pseudonimi di Maria e Anna, non vengono mai mostrate nella loro fisicità, nemmeno in forma alterata. Di solito, infatti, per mantenere anonima una persona intervistata in un programma televisivo si utilizzano varie strategie di alterazione dell’aspetto fisico. Normalmente il volto dell’intervistato può essere sfocato, pixelato; oppure si privilegiano inquadrature e angolazioni che non mostrano il viso, riprendendo solo mani, piedi, o il profilo in ombra. Molto spesso si utilizza anche un software per cambiare il tono, il timbro e il ritmo della voce, rendendola irriconoscibile.

In questo caso, invece, Le Iene hanno sostituito per intero l’aspetto delle testimoni con due immagini generate dall’intelligenza artificiale. Nei pochi minuti dell’intervista, si vedono infatti due avatar sintetici con le voci delle intervistate, una delle quali era anche alterata nel tono e nel timbro. Nell’angolo in basso a sinistra dello schermo, compariva invece un avviso: “Ricostruzione con intelligenza artificiale”.

Gli avatar di Maria e Anna imitavano il più possibile le espressioni del volto e la mimica facciale di una persona qualsiasi per riprodurre l’andamento di una normale conversazione. La scelta de Le Iene è abbastanza inusuale in Italia, ma riflette una delle tante contaminazioni sperimentali fra il mondo delle IA e quello del giornalismo. Le tecnologie di anonimizzazione basate su avatar generati dall’IA stanno infatti trovando applicazione in diversi contesti giornalistici e di advocacy per proteggere l’identità dei testimoni. Le tecniche classiche di anonimizzazione non garantiscono sempre una copertura totale della fisicità dell’intervistato, e possono quindi mettere a rischio la sua privacy o incolumità. Le immagini generate da intelligenze artificiali costituiscono quindi un ulteriore livello di protezione per gli intervistati.

I precedenti

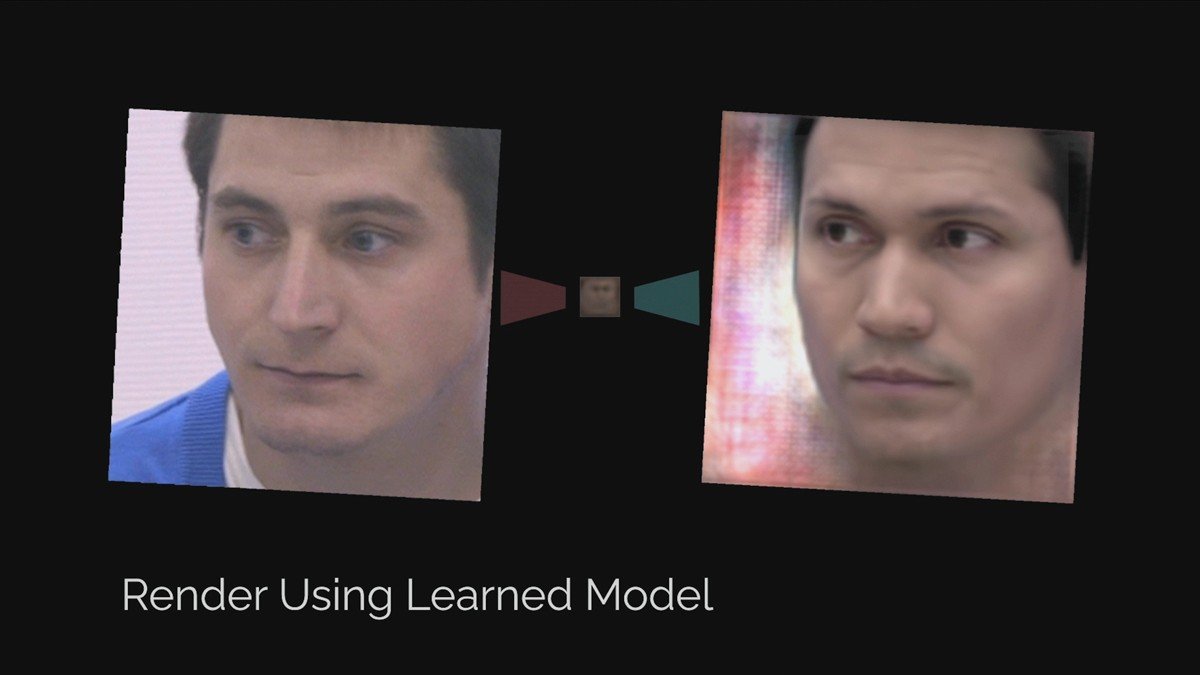

Nel documentario del 2020 Welcome to Chechnya, ad esempio, erano stati utilizzati volti alterati dall’IA per proteggere l’identità di attivisti LGBTQ+ in fuga dalle persecuzioni in Cecenia. In una lunga intervista, il regista del documentario, David France, ha spiegato come ha realizzato lo scambio di volti assieme al suo team.

Gli attori del documentario si sono prestati a essere filmati mentre replicavano i movimenti degli attivisti intervistati.

Successivamente, con strumenti di intelligenza artificiale e machine learning, i volti degli attori sono stati sovrapposti a quelli dei testimoni reali, mantenendo intatti la voce e il contesto delle interviste.

Ovviamente, la qualità delle immagini sintetiche utilizzate nel documentario di France non è paragonabile a quella della tecnologia disponibile nel 2024. Negli ultimi due anni, le intelligenze artificiali generative sono progredite moltissimo e spesso software vecchi di anche solo un anno risultano già obsoleti, se confrontati con quelli disponibili attualmente sul mercato. Tuttavia, la tecnologia impiegata da France e il suo team ha permesso di creare una sorta di “maschera digitale” che segue i movimenti e le emozioni del soggetto reale, rendendo l’effetto estremamente realistico.

I rischi di questa pratica

Ma potrebbero esserci anche dei rischi nell’utilizzo di IA generative per l’anonimizzazione dei testimoni. Un primo problema è che, a volte, questi tool possono essere stati addestrati su un insieme di dati statisticamente biased. Le IA generative, come modelli linguistici o di immagini, vengono addestrate su grandi quantità di dati prelevati da internet, libri, articoli e altre fonti. Se queste fonti contengono stereotipi di genere o razziali, l’IA potrebbe impararli e riprodurli, perpetrando così lo stereotipo.

Un altro rischio è invece quello di deumanizzare l’intervistato che si vuole rendere anonimo. Di norma, gli spettatori tendono a connettersi emotivamente con i volti degli intervistati; espressioni sottili, come un sopracciglio aggrottato o delle lacrime, in certi casi possono evocare una forte risposta emotiva. Anche se gli avatar IA replicano queste fattezze, il fatto che il volto non sia “genuino” e l’imitazione imperfetta può creare una barriera psicologica tra intervistato e spettatore. Certo, questo effetto può verificarsi anche, se non soprattutto, con le tecniche di anonimizzazione classiche, dove addirittura è frequente l’oscuramento totale del volto dell’intervistato. Tuttavia, gli avatar che riproducono in maniera imperfetta la fisionomia e le espressioni del volto in qualche caso possono addirittura risultare più sgradevoli della semplice sfocatura.

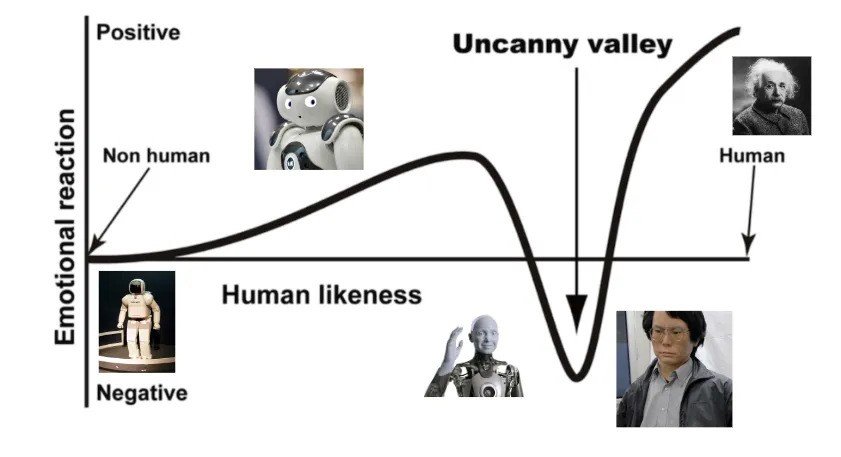

Gli avatar generati da IA, infatti, a volte sono percepiti come disturbanti quando sembrano realistici ma non completamente naturali; ad esempio, quando riproducono movimenti oculari innaturali o gesti rigidi. Questa reazione viene chiamata “uncanny valley effect”: una sensazione di disagio o repulsione che le persone provano quando osservano un oggetto, un robot o un’immagine digitale che appare quasi umana ma non del tutto convincente.

Questo effetto è stato descritto per la prima volta nel 1970 dal roboticista giapponese Masahiro Mori. Secondo Mori, la nostra reazione emotiva agli oggetti antropomorfi è descrivibile con un grafico a forma di valle.

Quando un oggetto sembra vagamente umano, come un robot stilizzato o un avatar semplice, questo suscita generalmente simpatia o interesse. Tuttavia, se l’oggetto diventa più realistico ma mantiene piccoli difetti – come movimenti rigidi, occhi privi di espressività o espressioni facciali bizzarre – inizia a sembrare inquietante (o “creepy”). Questo effetto è chiamato appunto da Mori «valle perturbante» perché indica un calo nella nostra risposta emotiva positiva; calo che nel grafico semplificato di Mori viene rappresentato come un forte avvallamento. Se invece l’oggetto diventa completamente indistinguibile da un essere umano, la nostra reazione torna a essere positiva, e l’inquietudine sparisce.

Sono state elaborate diverse teorie per spiegare l’uncanny valley effect. Una di queste ipotizza che la reazione emotiva di repulsione è causata dalla discrepanza fra le aspettative che abbiamo verso un oggetto e la sua apparenza. Quando un oggetto sembra umano ma non si comporta come ci aspettiamo (in questo caso, perché fa espressioni o movimenti strani), il contrasto tra le aspettative e la realtà genera una sensazione di inquietudine. È una reazione che può essere legata alla percezione di anomalie, che il nostro cervello potrebbe interpretare come un errore o una minaccia.

A prescindere da quale sia la teoria più convincente, però, l’uncanny valley effect può risultare un problema per l’uso di avatar a scopi giornalistici. Se infatti le immagini generate con IA dovessero suscitare repulsione nello spettatore, questo contribuirebbe alla deumanizzazione e al calo di empatia nei confronti dell’intervistato o della sua testimonianza. Tuttavia, rimane il fatto che finora solo pochi studi hanno trovato evidenze empiriche dell’esistenza di un uncanny valley effect; mentre altri fanno addirittura dubitare della sua fondatezza.

- Questo video del dietro le quinte di “Mamma ho perso l’aereo” è falsoQuesto video del dietro le quinte di “Mamma ho perso l’aereo” è falso

- L’IA non sa riconoscere i paper ritirati (e questo è un bel problema)

L’IA non sa riconoscere i paper ritirati (e questo è un bel problema)

L’IA non sa riconoscere i paper ritirati (e questo è un bel problema)