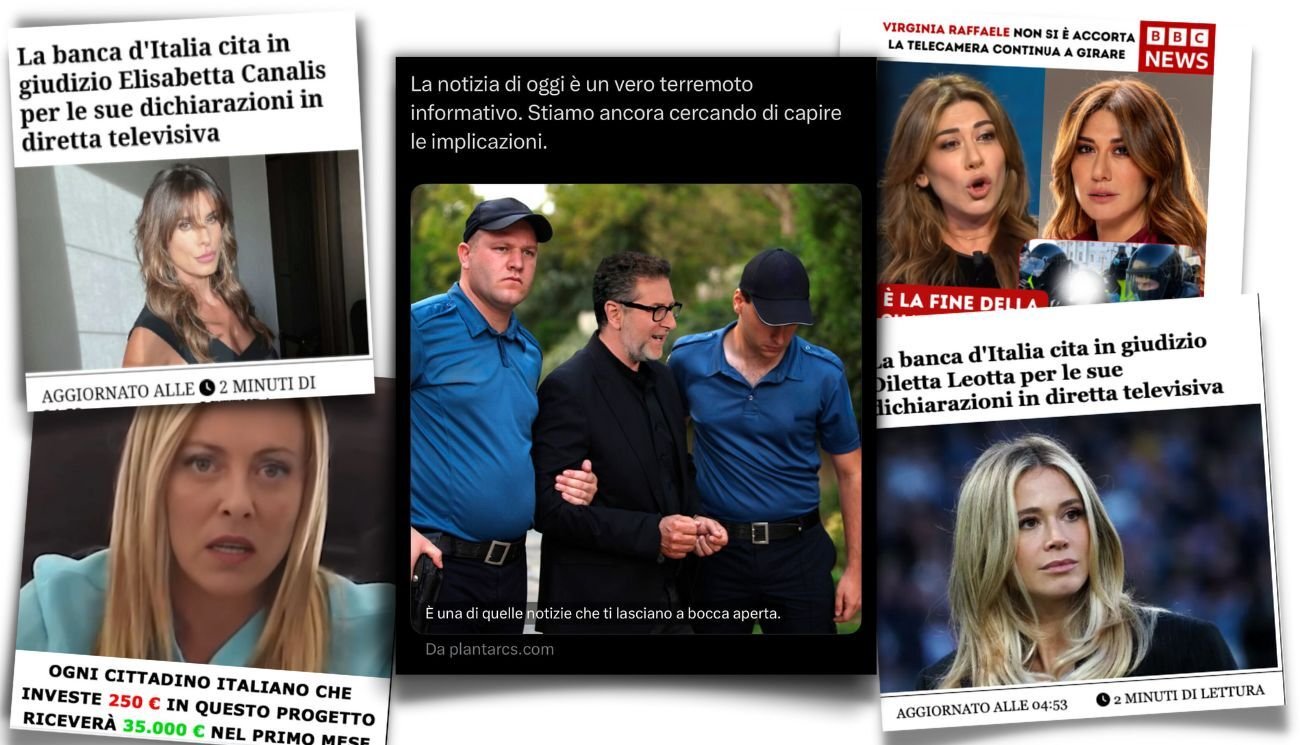

I deepfake stanno diventando una cosa seria

E stanno creando dei problemi sempre più complessi, soprattutto di carattere legale

Sempre più spesso l’attualità ci mette di fronte alle nuove sfide offerte dalla tecnologia, strumenti sviluppati con l’intento di rendere più semplici le nostre vite, ma che non di rado finiscono per presentare uno sgradevole rovescio della medaglia. È il caso, ad esempio, dei cosiddetti deepfake, termine con cui si indicano i risultati di una tecnica (e qualche volta anche la tecnica stessa) che parte da contenuti reali e che sfrutta l’apprendimento automatico dell’intelligenza artificiale per dare vita a una sintesi dell’immagine umana quasi del tutto indistinguibile dall’originale.

Tale tecnologia può avere applicazioni molto nobili, come la possibilità di restituire un corpo digitale a persone con gravi disabilità o di semplificare la ricerca medica, ma nel tempo ha dato vita anche a un prolifico filone di disinformazione, che sfrutta l’immagine di personalità pubbliche per veicolare messaggi falsi e pericolosi.

La minaccia dei contenuti deepfake è nota da tempo e Facta.news aveva già trattato l’argomento in passato, ma l’evoluzione tecnologica sta rendendo sempre più difficile distinguere la finzione dalla realtà. Uno stato di crescente confusione che si somma alla sostanziale impotenza delle autorità nazionali e sovranazionali, che fin qui si sono dotate di pochi strumenti e non ancora all’altezza del fenomeno.

Ma di cosa stiamo parlando esattamente?

Il termine deepfake è stato coniato nel 2017 dall’utente della piattaforma d’intrattenimento Reddit “deepfakes”, che aveva deciso di creare uno spazio digitale dedicato alla pubblicazione e allo scambio di filmati pornografici che includevano volti di personaggi famosi “montati” su corpi di attori e attrici di film per adulti.

La pagina arrivò in breve tempo a contare oltre 10 mila utenti e a contenere filmati che utilizzavano l’immagine di donne come Gal Gadot, Emma Watson e Scarlett Johansson senza il loro consenso, per renderle oggetto di fantasie sessuali. Una palese violazione della dignità delle vittime, ma che non poteva essere sanzionata dalla legge alla stregua della condivisione non consensuale di materiale intimo (il cosiddetto “revenge porn“), perché di fatto quei contenuti non riproducevano situazioni realmente avvenute. Anche davanti al vuoto legislativo, nel febbraio del 2018 Reddit decise autonomamente di proibire i deepfake dalla piattaforma, strada intrapresa a stretto giro anche da Twitter e da Pornhub.

La storia dei deepfake era però iniziata più di 20 anni prima in un laboratorio dell’università di Berkeley, in California, dove tre scienziati avevano dato vita al progetto Video Rewrite, con l’obiettivo di modificare riprese video esistenti di una persona che parlava, per sincronizzare il suo labiale con le parole contenute in una traccia audio diversa. Quel primo esperimento si era servito del machine learning, una tecnica di apprendimento automatico che consentiva all’intelligenza artificiale di creare collegamenti tra i suoni prodotti dal soggetto del video e la forma del suo viso, e ha aperto la strada a un vero e proprio filone di studi, ancora oggi molto attivo.

Oggi i deepfake non sono più semplicemente in grado di associare un suono a un movimento dei muscoli facciali, ma possono agire sull’intero corpo di una persona e farlo muovere o danzare in modo del tutto credibile, attraverso un’intelligenza artificiale più evoluta che può “apprendere” da una vasta libreria video di movimenti umani.

Deepfake e disinformazione

Per molto tempo la tecnologia alla base dei deepfake è stata pressoché inaccessibile al grande pubblico e riservata a una ristretta cerchia di ricercatori ed esperti in materia. Tutto questo è però cambiato a partire dal 2016, quando l’algoritmo Face2Face sviluppato da alcuni ricercatori tedeschi ha portato sui dispositivi di utenti e appassionati la possibilità di catturare le espressioni di una persona in tempo reale e riprodurle fedelmente sul viso di un secondo soggetto.

L’idea di trasformare le celebrità in testimonial inconsapevoli delle teorie più disparate ha immediatamente ingolosito la disinformazione, che si è tuffata con entusiasmo sul nuovo fenomeno. La corsa al deepfake è però rimasta un tema di nicchia almeno fino al 2018, quando l’ufficio stampa della Casa Bianca ha giustificato il ritiro dell’accredito stampa di un giornalista della Cnn, Jim Acosta, con il filmato di un suo presunto comportamento aggressivo. Solo in seguito si scoprì che il video era in realtà un deepfake utilizzato per screditare il cronista.

Pochi mesi più tardi, l’allora presidente degli Stati Uniti Donald Trump scelse invece di condividere con i suoi follower su Twitter un video amatoriale, per alcuni aspetti simile a un deepfake (e accostato ad esso da diversi media), che ritraeva l’esponente democratica Nancy Pelosi visibilmente ubriaca.

Il filmato, basato su un reale intervento di Pelosi ma rallentato del 75 per cento, generò un ampio dibattito sui pericoli posti dalla nuova tecnologia e su come le piattaforme di social media avrebbero dovuto affrontare la minaccia. La decisione di Facebook, in tal senso, fu quella di non rimuovere i filmati, ma di renderli meno visibili agli utenti, anche quando nel mirino della disinformazione deepfake finì lo stesso fondatore della compagnia Mark Zuckerberg.

Appena pochi mesi prima era stato lo stesso Donald Trump a essere vittima di un video deepfake, mandato in onda da un’emittente affiliata a Fox News e con lui, tra il 2018 e il 2019, subirono la stessa sorte anche l’ex cancelliera tedesca Angela Merkel e l’ex presidente argentino Mauricio Macrì. Nel 2020 il movimento ecologista Extinction Rebellion attribuì alla presidente belga Sophie Wilmès una falsa dichiarazione che collegava la pandemia di coronavirus ai cambiamenti climatici e nello stesso anno la campagna elettorale per la presidenza degli Stati Uniti fu costellata di video deepfake amatoriali che miravano a mettere in dubbio la salute mentale di Joe Biden.

L’applicazione più esemplare di questa tecnica è però arrivata all’indomani dell’invasione russa dell’Ucraina, in un contesto bellico già preso di mira dalla disinformazione tradizionale e dalla propaganda nazionalista. Il 17 marzo 2022 è così spuntato un video deepfake che imitava le sembianze del presidente ucraino Volodymyr Zelensky, mentre questi annunciava la resa del suo Paese. Qualche mese più tardi è comparso anche un falso Vitaly Klitschko, sindaco di Kiev, che secondo fonti stampa ucraine avrebbe addirittura intrattenuto conversazioni in videoconferenza con il sindaco di Berlino e con quello di Madrid. Una dinamica pericolosa, che in uno scenario delicato come quello ucraino avrebbe potuto avere delle conseguenze imprevedibili.

In Italia il fenomeno dei deepfake si è manifestato relativamente tardi e ha iniziato a far parlare di sé nel 2019, quando il varietà di Canale 5 Striscia la Notizia ha trasmesso una clip che ritraeva un falso Matteo Renzi durante un fuori onda. In questo caso, come in molti degli episodi citati in precedenza, la qualità del deepfake mostrava un certo margine di perfettibilità, che ha consentito agli osservatori più attenti di percepire la manipolazione. Le frontiere dell’apprendimento automatico sono tuttavia ancora inesplorate e le potenzialità di questo strumento virtualmente infinite. Non resta che chiedersi cosa succederà quando l’intelligenza artificiale sarà del tutto indistinguibile dalla vita reale.

Non solo disinformazione politica

Come abbiamo accennato in precedenza, il primo utilizzo noto dello strumento deepfake ha preso di mira la categoria delle celebrità e più precisamente quella delle attrici e delle cantanti donne. Lo sfruttamento dell’immagine femminile attraverso l’intelligenza artificiale è stata però una costante nell’evoluzione della disinformazione collegata ai deepfake e rappresenta ancora oggi la fetta maggiore di questo mercato della manipolazione.

Secondo un’inchiesta condotta da Nbc, il numero di video deepfake a sfondo pornografico è raddoppiato ogni anno a partire dal 2018 e il mese di febbraio 2023 ha battuto ogni record per numero di upload in questa categoria. Questo anche grazie al caso dello streamer di Twitch Atrioc (al secolo Brandon Ewing, oltre 315 mila follower) che ha ammesso pubblicamente di aver acquistato e guardato video deepfake che ritraevano alcune sue colleghe in atteggiamenti sessualmente espliciti.

La stessa inchiesta della Nbc ha inoltre svelato l’esistenza di un’applicazione scaricabile dai principali app store che permetteva di creare video deepfake con estrema facilità. L’app era stata sponsorizzata circa 230 volte su Facebook, Instagram e Messenger, utilizzando video manipolati di Emma Watson e Scarlett Johansson in pose ammiccanti e atteggiamenti sessualizzati. Il 7 marzo Meta ha rimosso gli annunci e Apple ha cancellato l’applicazione dal suo store, che resta comunque disponibile su Google Play.

Ma non è necessario essere una personalità pubblica per essere esposti a questa nuova forma di violenza. Attraverso Telegram è infatti possibile acquistare diversi bot che eliminano i vestiti a qualsiasi foto di donna, rendendo chiunque un potenziale bersaglio di contenuti sessuali non consensuali che mirano all’umiliazione e alla discriminazione.

Attualmente non esiste in Italia un quadro normativo in materia di deepfake in grado di contrastare il fenomeno e ogni iniziativa in tal senso è affidata all’art. 612-ter del codice penale, che punisce la fattispecie della condivisione non consensuale di materiale intimo. Tale norma non è però mai stata applicata al deepfake ed esistono dubbi concreti circa la sua effettiva applicabilità in materia di condivisione di materiale creato da un’intelligenza artificiale.

In conclusione

Negli ultimi anni l’attualità ci ha posto di fronte numerosi casi di disinformazione prodotti attraverso il deepfake, una tecnologia che permette di dare vita a una sintesi dell’immagine umana quasi del tutto indistinguibile dall’originale. Nonostante il primo utilizzo amatoriale dello strumento risalga al 2017, la tecnologia che ha reso possibile la creazione dei video ha una storia molto più lunga e ha avuto origine nel mondo accademico degli anni Novanta.

Per molto tempo la tecnologia alla base dei deepfake è stata pressoché inaccessibile al grande pubblico e riservata a una ristretta cerchia di ricercatori ed esperti in materia, ma negli ultimi anni è stata sfruttata per creare video manipolati di personalità politiche e celebrità, ma anche per umiliare e discriminare tante donne non esposte pubblicamente. Attualmente non esiste in Italia un quadro normativo in materia di deepfake in grado di contrastare il fenomeno e ci sono seri dubbi che alla fattispecie possa essere applicato l’articolo del codice penale che punisce il revenge porn.

- “Elena Ferrante è morta”. L’ultima bugia di Tommaso Debenedetti, il più noto “falsario” del giornalismo italiano

“Elena Ferrante è morta”. L’ultima bugia di Tommaso Debenedetti, il più noto “falsario” del giornalismo italiano

“Elena Ferrante è morta”. L’ultima bugia di Tommaso Debenedetti, il più noto “falsario” del giornalismo italiano - Questa foto del militare iraniano con indosso vestiti femminili è falsaQuesta foto del militare iraniano con indosso vestiti femminili è falsa