Videogame, immagini GAN e deepfake: un viaggio nella disinformazione creata dalla tecnologia

Che cosa succede quando tecnologia e disinformazione si incontrano

La disinformazione che raccontiamo con il lavoro quotidiano di Facta può assumere molte forme, che nel corso del tempo abbiamo cercato di sintetizzare in alcune categorie utili a orientarsi. Al di là del “verdetto” che la nostra redazione assegna ad una notizia, in molti casi il dettaglio in grado di fare la differenza è la forma stessa con cui una falsa notizia è stata diffusa.

In un nostro precedente articolo abbiamo sintetizzato alcuni utili consigli per difendersi dalla disinformazione, ma cosa fare quando ciò che stiamo combattendo… non esiste? Certo, si potrebbe obiettare che una notizia falsa è per definizione una notizia che non esiste, ma alcune notizie false lo sono in un certo senso più di altre, perché includono foto e filmati creati da zero sfruttando sofisticati strumenti tecnologici e che dunque non appartengono alla realtà.

È il caso dei video tratti dai videogame, giunti a un grado di realismo tale da risultare difficilmente indistinguibili dai filmati genuini, ma anche delle cosiddette immagini Gan e dei video deepfake, che sfruttano le potenzialità dell’intelligenza artificiale per riprodurre in modo estremamente realistico alcune caratteristiche o movimenti propri del corpo umano. Scopriamo di che si tratta.

Se la disinformazione arriva dai videogame

Tra i più diffusi casi di disinformazione creati dalla tecnologia c’è quello che riguarda gli estratti dei videogame spacciati per filmati di attualità, divenuti, ad esempio, popolari in seguito all’invasione russa dell’Ucraina avvenuta il 24 febbraio 2022. Il meccanismo è semplice ma molto efficace, e consiste nel decontestualizzare uno o più spezzoni tratti da videogame che simulano combattimenti aerei, presentandoli come immagini esclusive di un presunto bombardamento avvenuto in Ucraina.

Questa tipologia di falsi contenuti sfrutta l’estremo realismo raggiunto dalla computer grafica applicata ai videogame e una tendenza sempre maggiore allo streaming in diretta di sessioni di gaming ospitate da videogiocatori professionisti, che permette di avere accesso a lunghi filmati in alta qualità di battaglie simulate. A ciò si aggiunge il formato stesso alla base dei videogiochi di simulazione, che cercano di riprodurre l’esperienza reale di un combattimento aereo offrendo una visuale in prima persona (ovvero, il giocatore vede sullo schermo ciò a cui assisterebbe se si trovasse nei panni di un vero pilota).

Mescolando questa lista di ingredienti, la disinformazione è servita. Già il 21 febbraio – e quindi tre giorni prima dell’inizio ufficiale dell’invasione – ci eravamo occupati di verificare un contenuto che sembrava annunciare l’inizio del conflitto russo-ucraino, allegando come prova un presunto scontro aereo tra i due Paesi. Le immagini provenivano in realtà da un livestream (ossia di una trasmissione in diretta) di un videogioco chiamato Arma 3. Il 24 febbraio 2022, lo stesso videogame era stato utilizzato (in modo errato) come la prova di un «attacco antiaereo ucraino» avvenuto durante il primo giorno di conflitto.

Complice la scarsità di testimonianze filmate nei primi giorni di guerra, questo formato di disinformazione non ha ingannato solo gli utenti di internet, ma è arrivato fin nelle redazioni giornalistiche. Ad esempio, il 24 febbraio 2022 il TG2 Rai delle ore 13 ha mandato in onda un servizio contenente le immagini di «una pioggia di missili» caduti sull’Ucraina, che si sono rivelate essere lo spezzone del videogame di tattica bellica War Thunder.

Le immagini GAN

Se le clip tratte dai videogiochi possono essere verificate ricercando la prima apparizione su Internet del filmato decontestualizzato, molto diverso è il discorso da fare per le immagini create da zero con l’intenzione di replicare volti umani. Parliamo delle cosiddette immagini Gan, ovvero di fotografie generate da un’intelligenza artificiale e del tutto indistinguibili da quelle reali.

Nei mesi scorsi ci siamo imbattuti in un caso esemplificativo di questa dinamica, quando su Facebook è comparsa la storia del diciassettenne “Magon D’Aloia”, che sarebbe stato sospeso da scuola a causa di un tema «contro la dittatura sanitaria». I post comparsi sui social network contenevano anche una presunta foto del ragazzo, immortalato in un primo piano sorridente. Come abbiamo spiegato in un articolo dedicato all’argomento, “Magon D’Aloia” non esiste e il racconto della sua disavventura è stato inventato da un account che già in passato aveva dato vita a notizie false sui vaccini.

La maggior parte di questi contenuti di disinformazione allegava foto delle presunte vittime, ritratte immancabilmente in primo piano, con lo sfondo sfocato e alcune impercettibili imperfezioni estetiche a segnare il volto o i capelli. Come nel caso di “Giulia”, una presunta diciannovenne di Torino che sarebbe finita in coma dopo essere stata picchiata per essere entrata in un supermercato senza mascherina. Storia ancora una volta falsa, accompagnata da una foto inesistente. A pubblicare questi contenuti è un utente che scrive sotto lo pseudonimo di “Beatrice Juvenal”, che si descrive come una «giornalista indipendente» e che come immagine del profilo utilizza – indovinate? – foto di persone inesistenti.

In tutti questi casi ci siamo trovati di fronte a immagini Gan, utilizzate per dare un volto alle vittime a aggiungere credibilità alle storie raccontate. Non esistono vere e proprie strategie utili a difendersi da questo tipo di disinformazione, se non mantenere una mente elastica e un occhio allenato: a tal proposito vi consigliamo di utilizzare questo sito web, che propone di volta in volta un’immagine reale e un’immagine Gan, chiedendo all’utente di scegliere quale delle due corrisponda a una persona in carne e ossa. In bocca al lupo e buon divertimento!

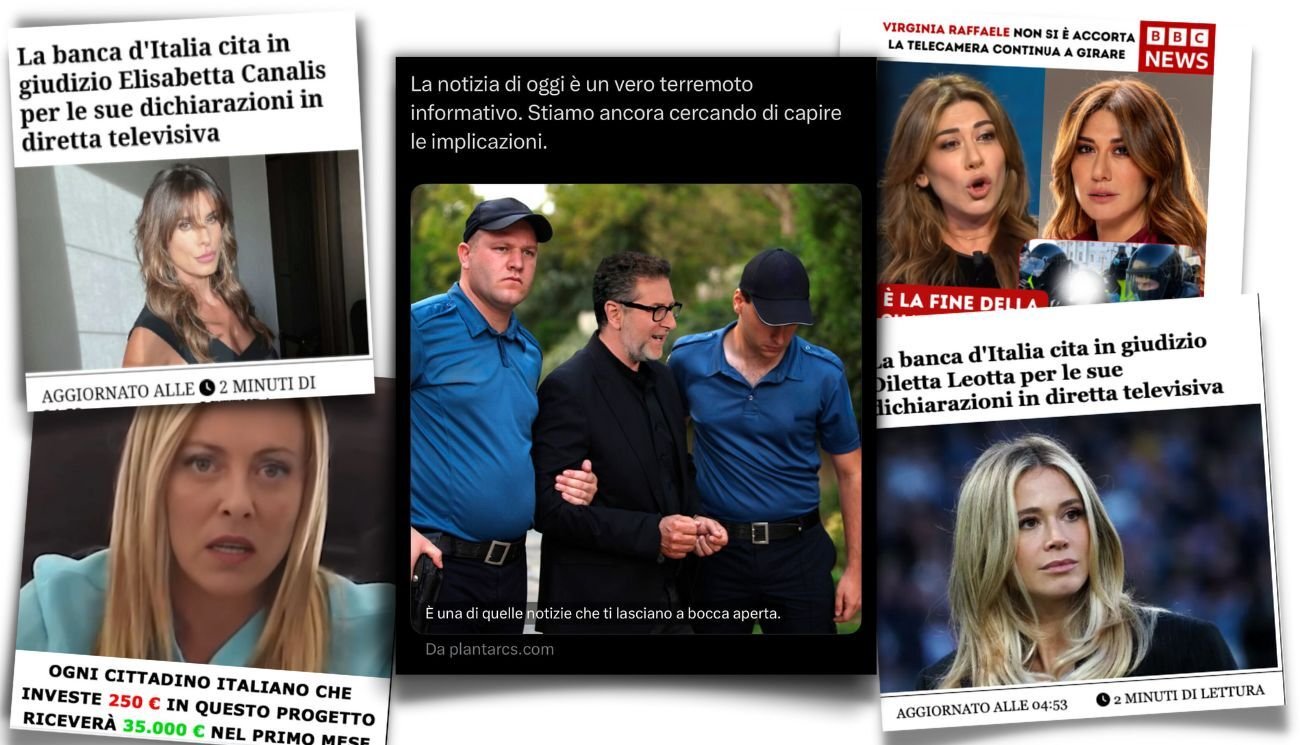

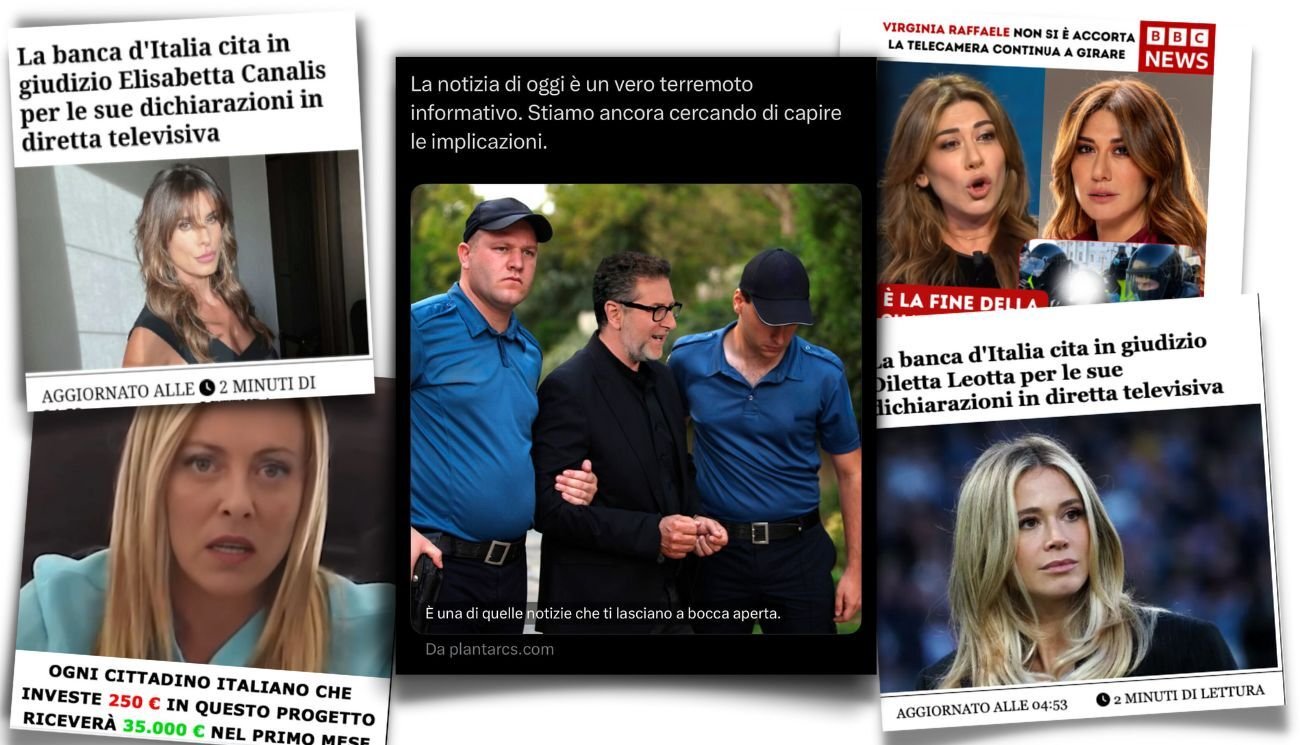

Deepfake, ma non solo

Tra gli strumenti di disinformazione più insidiosi, pescando tra quelli creati dalla tecnologia, c’è sicuramente il cosiddetto deepfake, una tecnica che parte da immagini reali e che sfrutta l’apprendimento automatico dell’intelligenza artificiale per dare vita a filmati del tutto originali, con personalità pubbliche come ignari protagonisti. Per fare un esempio molto concreto: avete mai visto il video con cui il presidente ucraino Volodymyr Zelensky ordinava alle truppe del suo Paese di deporre le armi? Ecco, si trattava di un deepfake.

Vale la pena precisare che, nel momento in cui scriviamo, la tecnologia alla base dei deepfake è ancora perfettibile e che la maggior parte dei filmati pubblicati contiene movimenti goffi e innaturali (come nel caso del falso fuorionda di Matteo Renzi trasmesso nel 2019 da Striscia la Notizia). Le frontiere dell’apprendimento automatico sono tuttavia ancora inesplorate e le potenzialità di questo strumento virtualmente infinite, basti pensare a cosa potrebbe accadere se uno stimato medico fosse utilizzato per veicolare un trattamento sanitario dannoso, o se le fattezze di un leader politico fossero sfruttate per incitare azioni violente.

Il deepfake non è tuttavia l’unica insidia che la tecnologia pone al campo dei contenuti audiovisivi. Nei mesi scorsi la redazione di Facta ha ricevuto numerose segnalazioni che chiedevano conto di alcune strane interviste televisive, contenenti lunghi silenzi o risate fuori luogo ad opera di Matteo Salvini, Giorgia Meloni e Luigi Di Maio.

In tutti e tre i casi si trattava di contenuti satirici estrapolati dalla trasmissione di La7 Propaganda Live e pubblicati sui social network senza il contesto necessario alla loro comprensione. È ciò che in gergo viene definito un cheapfake, ovvero un video manipolato attraverso la modifica dell’audio, il rallentamento dei frame o la sostituzione in un’immagine con un’altra: non un contenuto creato da zero attraverso un’intelligenza artificiale, insomma, ma comunque in grado di ingannare l’utente medio di Internet.

In casi come questo – o come quello dei deepfake – la prima linea di protezione consiste nella consapevolezza che questi strumenti esistono e che la tecnologia è una risorsa preziosa, ma che nelle mani sbagliate può essere utilizzata per fini fraudolenti. La seconda linea di difesa è come sempre il nostro numero WhatsApp, al quale potete rivolgervi per qualsiasi dubbio sui contenuti incontrati online.

In conclusione

La disinformazione è, di per sé, insidiosa ma lo diventa ancora di più quando trova nella tecnologia un valido alleato. I filmati estratti da videogame e decontestualizzati, le foto create da zero con l’intento di dare un (falso) volto a storie inventate, e i video che sembrano mostrare personaggi celebri compiere azioni o dire cose in realtà mai avvenute sono solo alcuni esempi di come la cattiva informazione è in grado di entrare nella quotidianità dei cittadini.

Come fare, quindi, per difendersi? Familiarizzare con i filmati realizzati al computer, con le immagini Gan, con deepfake e cheapfake è il primo passo per riconoscere online contenuti di questo tipo ed esaminarli in modo critico. Vale poi la solita regola generale: mai condividere un contenuto se non si è certi che si tratti di un’informazione verificata e affidabile.

E… se avete dei dubbi, segnalateci la notizia. Ci pensiamo noi di Facta!

- Non è vero che la fondazione di Olena Zelenska gestisce un traffico di bambiniNon è vero che la fondazione di Olena Zelenska gestisce un traffico di bambini

- Il ministro Crosetto non ha pubblicato questo tweet sul reato di associazione mafiosaIl ministro Crosetto non ha pubblicato questo tweet sul reato di associazione mafiosa